Bienvenido al Prompt, la newsletter sobre Inteligencia Artificial escrita con un poco de Inteligencia Natural

¡Hola prompters! 25 de Noviembre. Newsletter #13. Esta semana todos han sacado músculo: Google con Nano Banana Pro nos deja fotos que parecen reales, OpenAI y Anthropic contraatacan con modelos especialistas en código, y Meta ha presentado la última versión de uno de sus mejores modelos para segmentar cualquier objeto en cualquier imagen.

Ya anticipamos que Gemini 3 Pro no sería lo último que sacaría Google, y a los pocos días, nos regaló Nano Banana Pro para creación de imágenes. La competencia se tuvo que poner las pilas y han sacado sus últimos modelos para programar, como diciendo "Vale, quizás no tenemos el mejor modelo general, pero mira lo que hacemos en nuestro terreno" (que tampoco es que Gemini 3 Pro sea manca programando…).

Mientras tanto, OpenAI ha hecho un movimiento que todavía estoy intentando descifrar y Anthropic sigue a lo suyo: siendo los más seguros de la clase, y sospechando siempre de China pero esta vez con una historia de película.

Vamos al lío, que hoy hay mucho que comentar.

>>> Tres noticias destacadas

🍌 Google presenta Nano Banana Pro: La IA que genera fotos tan reales que da miedo

💻 La respuesta de los rivales: GPT Codex Max 5.1 y Claude Opus 4.5 llegan para programar mejor que nadie

🖌 Meta lanza SAM 3: El modelo que ganaría al "Buscando a Wally" (y ayuda a detectar tumores)

>>> HistorIAs de la IA

👤 Quién es quién 👤: Demis Hassabis. Cumplimos la promesa de la semana pasada: os traigo al científico genio detrás de Google DeepMind. Si Sundar Pichai es el CEO gestor, Demis Hassabis es el visionario. Del ajedrez infantil al Nobel de Química.

>>> Una herramienta

🛠 Antigravity: Antigravity: El nuevo IDE de Google donde la IA programa por ti (literalmente)

Y para la canción de la semana, nos ponemos juguetones. Esta vez traigo una canción con inspiración en aquel maravilloso movimiento de los años 90: el tontipop. Pese a su apariencia sencilla, inocente y juguetona, el tontipop en realidad traía profundidad en las letras y canciones. Igual que NanoBanana, que parece que es un modelo que sólo vale para hacer montajes graciosos, pero puede acabar el rey de la creación y edición de contenido en marketing, diseño y demás

¿Qué ha pasado esta semana en el mundo de la IA?

La semana pasada Google nos dejó con la boca abierta con Gemini 3 Pro. Pero la gente sabía que eso no iba a ser todo. Muchos esperaban que también sacasen una actualización de su modelo estrella para creación de imágenes, y así fue. El jueves 20 de Noviembre salió Nano Banana Pro, la versión evolucionada de su ya famoso “Nano Banana” (su nombre oficial es Gemini 2.5 Flash Image, pero nadie lo conoce así, sino con el pseudónimo que usó cuando aún estaba en pruebas de manera anónima en LMArena). Si te da pereza seguir leyendo, pero tienes curiosidad de ver de lo que es capaz, te pongo un par de links donde puedes ver algunos ejemplos de lo que puede hacer el modelo. Entra en el post oficial de Google, o el análogo en Deepmind, para verlo.

El timing del lanzamiento no es casualidad. Con Gemini 3 dominando el texto y el razonamiento, Nano Banana Pro completa el ecosistema. Google está diciendo: "No solo tenemos el mejor modelo de lenguaje, también tenemos la mejor generación de imágenes". Y de momento, pocos pueden discutirlo, porque lo que trae la actualización de Nano Banana no es poco:

1. Fotorrealismo a alta resolución: No es solo que las imágenes sean bonitas. Es que son creíbles. El modelo entiende cómo funciona la luz, cómo se comportan los materiales, y cómo debería verse una escena si fuera real. Y se acabó el límite de resolución de 1024×1024 píxeles. El nuevo modelo podrá generar imágenes de 2K y 4K, y al formato que le pidas, no solamente cuadrado, como lo hacía el anterior, en su lanzamiento.

2. Razonamiento antes de ponerse a “dibujar”: Uno de los mayores avances es que ahora Nano Banana Pro está diseñado para trabajar mano a mano con Gemini 3. Puedes describir una escena compleja en lenguaje natural, Gemini entiende tu intención, y Nano Banana Pro la materializa.

Una prueba de su capacidad de razonamiento. Le pedí que generase una imagen de la mañana del 6 de Junio de 1944 en las coordenadas que veis, que se corresponden con la fecha y coordenadas GPS del desembarco de Normandía. El modelo ha entendido lo que pedía, y ha generado lo que pedía. Hasta le ha puesto las coordenadas con letrita típica de máquina de escribir de la época.

3. Control creativo sin precedentes y consistencia de personajes: Gracias a su razonamiento, puedes especificar no solo qué quieres, sino cómo lo quieres. Ángulo de cámara, tipo de iluminación, estilo fotográfico. Es como tener un equipo completo de producción fotográfica a tu disposición. Y puedes añadir hasta 14 objetos distintos, y mantendrá la consistencia de hasta cinco personajes que le digas que incluya

Para hacer esta imagen, el prompt fue algo así como ” Combina estas imágenes y colócalas adecuadamente, todo en una imagen 16:9. Pon el vestido sobre el maniquí”. Hasta la sombra de los objetos es realista… Yo si fuera de marketing estaría pagando ya la suscripción anual

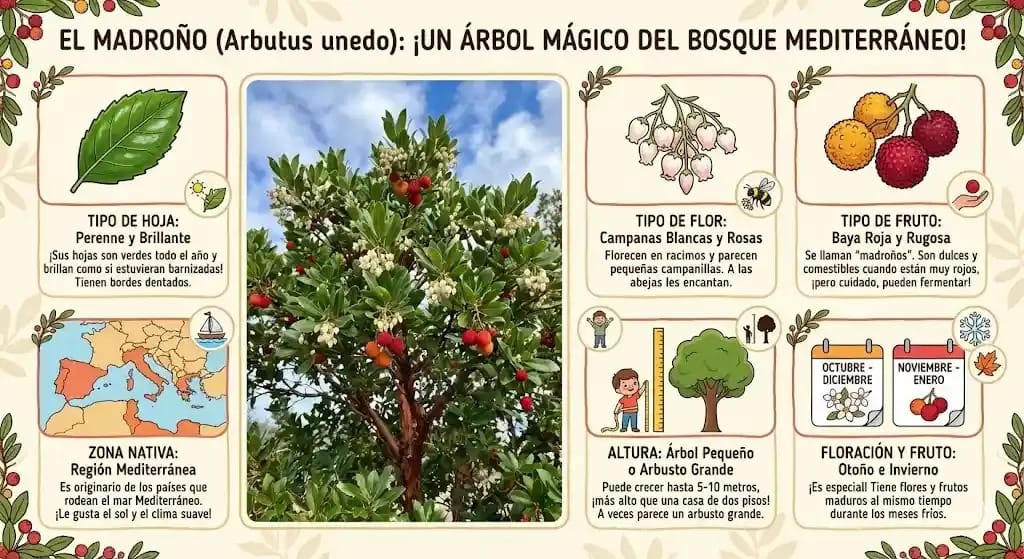

4. Alta fidelidad y calidad texto: Uno de los talones de Aquiles de la generación de imágenes es la inclusión de texto. Bueno, lo era. Ya no. Con Nano Banana Pro puedes pedir anotaciones, acotaciones, y todo lo que se te ocurra, que todo lo que cree será legible. ¿Que tienes que hacer un trabajo sobre un árbol para explicárselo a unos niños? Pues en un prompt tienes la infografía hecha.

Esta infografía la he hecho a la primera, con el siguiente prompt (erratas incluidas) “Ahora crea una infografía del madroño (arbutus unedo). Muestra una imagen fotorrealista del árbol, y además, muestra en dibuojs o ilustraciones sus mayores característics. tipo de fruto. zona de la que es nativo, tipo de hoja, y de flor, fecha de floracion y fruto, altura, etc. Haz la infografía enfocada a niños y en español” No me cuido ni de no poner erratas, porque me va a entender igual. Y esto, con NanoBanana, no era igual, creedme, que lo intenté. El texto no era legible, se inventaba la forma de la flor, te pintaba fresas en lugar de madroños…

Una de las mayores ventajas competitivas de Google frente a sus rivales OpenAI, Anthropic, xAI o las análogas chinas, es su capacidad de integrar sus modelos en el enorme ecosistema que tiene. En este caso, Nano Banana Pro ya ha sido integrado en varias de sus herramientas: lo tienes disponible en la app de Gemini, en Google AI Studio, para resúmenes de NotebookLM, para crear vídeos con Flow, para diseñar interfaces profesionales en Vertex AI o Antigravity, para generar anuncios de Google Ads… y así una larga lista. Y si quieres usarlo tú, simplemente ve a la página de Gemini y selecciona la opción de Crear Imágenes. No tiene pérdida, solo busca el iconito del plátano 🍌 .

Y además, siempre ponen énfasis en cómo detectar si una imagen ha sido generada por sus modelos (y viendo el fotorrealismo, se agradece porque uno ya no sabe…). Cada imagen generada lleva marcas de agua invisibles (SynthID) para identificarla como creada por IA, y tienen filtros robustos para evitar deepfakes dañinos o contenido problemático. (Si quieres saber más sobre la tecnología de SynthID, puedes leer más en el post que hice sobre eso en mi blog:

Mientras Google celebraba el lanzamiento de Nano Banana Pro, OpenAI y Anthropic no se quedaron quietos. Ambos lanzaron actualizaciones la misma semana, casi de forma coordinada, como si hubieran acordado responder al gigante de Mountain View al mismo tiempo. Y la estrategia ha sido clara: "Quizás no tengamos el mejor modelo general, pero mira lo que podemos hacer en programación".

💻 La respuesta de los rivales: GPT Codex Max 5.1 y Claude Opus 4.5 para programar mejor que nadie

El 19 de Noviembre, tan solo un día despues del lanzamiento de Gemini 3 Pro, OpenAI lanzaba su modelo más avanzado especializado en programación. El GPT 5.1 Codex Max. Una versión mejorada de su existente Codex, que está hiperespecializado en generación de código. No solo es muy bueno escribiendo código, sino que lo hace de manera más eficiente. De hecho, en OpenAI lo venden como el primer modelo entrenado específicamente para poder trabajar y programar a lo largo de varias sesiones de contexto. ¿Cómo? La clave es la "compactación contextual": trabaja con millones de líneas sin perder el hilo. Es como si tan solo tienes 10 páginas para hacer un trabajo, pero cuando estás llegando al final, resumen todo lo que llevas en media página, y sigues escribiendo en las otras nueve y media que se han quedado libres. El problema de las ventanas de contexto en modelos de programación es conocido, y en OpenAI son conscientes y parece que lo están resolviendo. Pero no solo en OpenAI…

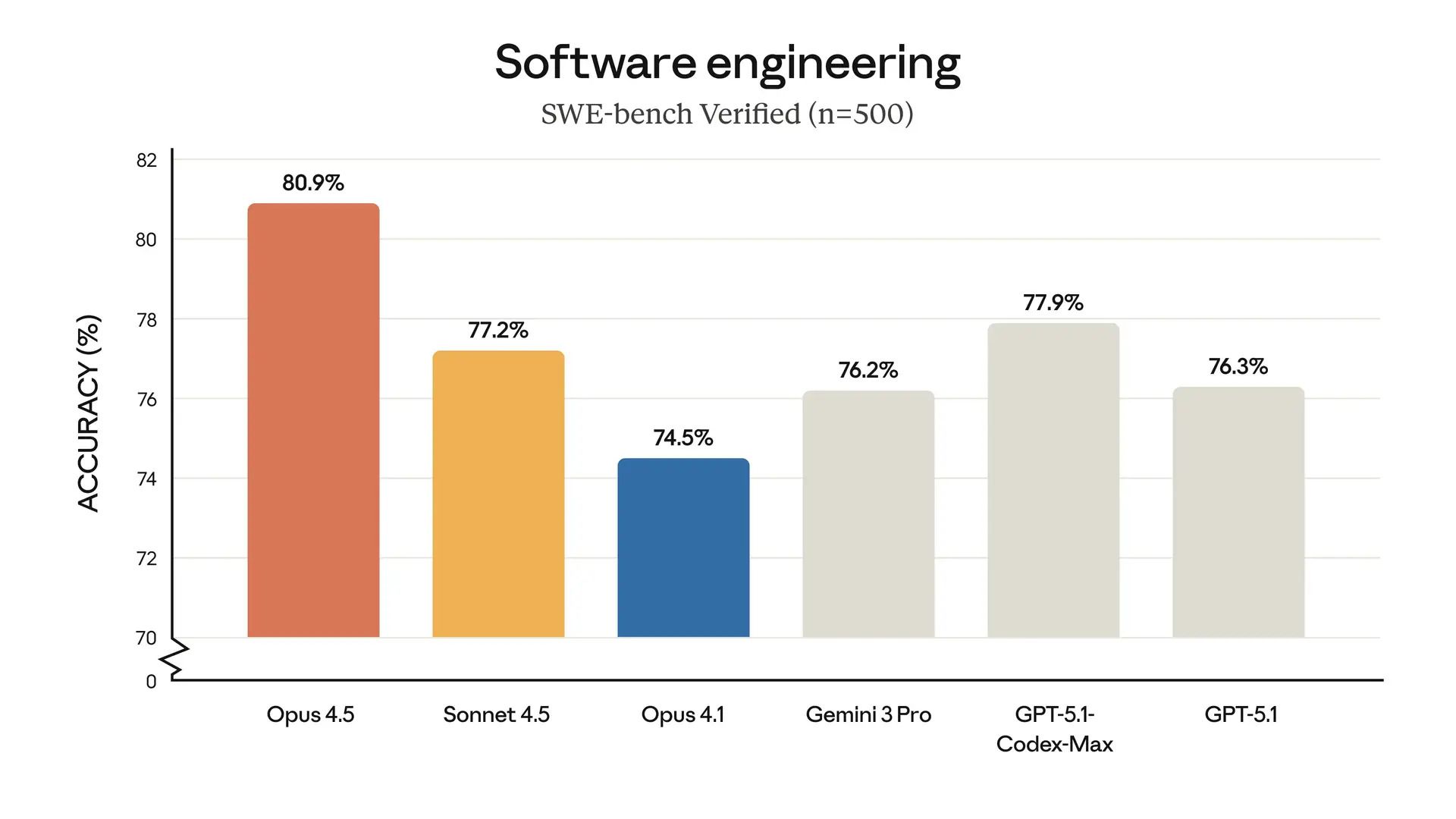

Apenas unos días más tarde, el 24 de Noviembre, Anthropic presentaba el modelo más pesado y avanzado que tenían. El Claude Opus 4.5. El rey de los modelos de programación, junto con Codex, era el otro modelo de Anthropic Claud Sonnet 4.5. De hecho, el benchmark de programación era uno de los muy pocos en lo que Gemini no se puso líder en su salida, al no poder superar a Claude Sonnet 4.5. Pero en Anthropic tenían este as bajo la manga, y parece evidente que han estado esperando a que Gemini sacara su modelo 3, para anunciar Claude Opus 4.5.

Claude Opus 4.5 se pone a la cabeza en el benchmark de escribir código correctamente, seguido por el nuevo GPT 5.1 Codex Max, y Sonnet 4.5, también de Anthropic.

Al igual que OpenAI con su GPT Codex Max 5.1, Anthropic se ha centrado en hacer que su modelo pueda trabajar bien a lo largo de varias sesiones de contexto. Ahora mismo todos estos modelos ya programan decentemente. Te pueden hacer casi cualquier ejercicio simple de programación con la misma o mejor precisión que un humano (de hecho, dice Anthropic que puso a prueba a su modelo a los mismos exámenes internos a los que se enfrentan sus ingenieros, y obtuvo mejor puntuación que cualquiera de ellos). Pero donde aún queda por mejorar es en códigos realmente largos, esos de miles de líneas, o cientos de archivos. Los modelos actuales no tienen la memoria ni la habilidad de mantener en contexto toda la información, y se acaban perdiendo, si no al menos sufriendo mucho.

Pero Anthropic también ha trabajado mucho en este problema. Además de también incluir la compactación de la que hablábamos más arriba, ha introducido lo que llaman “Tool Search Tool”, o “herramienta de búsqueda de herramientas”. Y con ello han conseguido un modelo no solo más inteligente, sino mucho más eficiente, y por tanto, con más capacidad, y más barato.

¿En qué consiste el “Tool Search Tool”? Te lo explico con un ejemplo.

Imagina que el modelo es un estudiante en una biblioteca. Tiene que resolver unos problemas en su hoja, y tiene acceso a todos los libros de la biblioteca. Pero hay un problema. La mesa en la que está no es lo suficientemente grande para traer todos los libros que querría. Si tiene un problema que no sabe resolver, se va a por libros y se los trae a la mesa, pero en cuando lleva 10 o 12 libros, la mesa ya está llena, y no caben más. No puede consultar otras cosas, o trae otro y se le cae el primero… un lío. Una solución podría ser “ser más inteligente”, es decir, usar menos libros. Pero cuando hay problemas complejos tiene que usar libros sí o sí. Entonces, se le ocurre una idea, la “Tool Search Tool”, un mecanismo en el que no tiene por qué traer los libros a la mesa, sino usar un punto intermedio en el que conseguir la información que necesita de los libros sin ocupar más mesa. Es como irse a consultar al libro, y quedarse memorizando en la estantería lo que necesita, y volverse sin el libro, para no ocupar la mesa. Así es como están haciendo en Anthropic que sus modelos sean más eficientes, y por tanto los mejores para programar.

Con este truco, ahorran muchos tokens. En este ejemplo sin usar el Tool Search Tool, les quedan ~122k token, frente a ~193k libres cuando lo usan.

Aún hay mucho que resolver para hacer los mejores agentes y modelos de programación, pero está claro que en estas grandes compañías, no les faltan recursos, ni ideas, para resolver los problemas que van saliendo, al menos de momento

Y ahora nos dejamos de nuevos modelos y lanzamientos (tranquilos, que las próximas semanas vienen repletas de más lanzamientos), y vamos con algo más salseante y a la vez, preocupante. El primer ciberataque orquestado por una IA.

Los anteriores modelos tienen, y tendrán, en mayor medida, aplicación directa en la investigación. Pero uno que ya tiene un uso muy extendido en la imagen médica es el llamado “Segment Anything” de Meta. La primera versión del Segment Anything (o SAM) fue publicado en 2023 (aquí el preprint original). Era un modelo de segmentación que podría segmentar prácticamente cualquier objeto en cualquier imagen. Para los no iniciados en el maravilloso mundo de la segmentación, segmentar es la habilidad de identificar y aislar cualquier objeto en una imagen o vídeo, desde el sticker que haces manteniendo el dedo apretado en una foto de tu iphone hasta el tumor que detecta automáticamente una herramienta de análisis de un hospital, que le puede decir al cirujano qué volumen exactamente tiene que extirpar. Bueno, pues Meta presentó hace un par de años su modelo SAM, y desde entonces, no solo ha ido publicando actualizaciones, sino todo el código del modelo para que cualquier investigador lo pueda aplicar a su ámbito (aquí el repositorio de github).

Pues bien, el pasado 19 de noviembre Meta sacó la versión 3 de este modelo. De hecho, hizo un 2×1 y sacó otro modelo, el SAM 3D, que permite crear reconstrucciones 3D a partir de una sola imagen. Si quieres explorar un poco de lo que es capaz, tienen su propio playground aquí donde puedes subir cualquier imagen y pedir que te la segmente. Lo que sea.

Aquí un ejemplo de uso en su playground. Le subí la foto anterior de la infografía del madroño y le pedí que segmentara “la fruta” sin más descripción. Y lo resaltara y sombreara lo que no era fruta. No encontró todas, pero con la baja calidad de la imagen y de mi petición, el resultado es asombroso.

¿Por qué la segmentación es importante? Porque es la tecnología invisible que alimenta cientos de apps. Edición de fotos (lo típico de quitar fondo, o seleccionar inteligentemente a tal individuo), producción de vídeo (efectos especiales automatizados), medicina (análisis de diagnósticos), agricultura (drones analizando cultivos), robótica (visión por computador), industria militar (detección de objetos y personas en tiempo real)...

Un pequeño resumen de cómo funciona el modelo. No sólo segmenta lo que sea, sino que propaga la selección en vídeo. Y puedes utilizar lenguaje natural para detectar lo que buscas.

Y la mejor noticia es que Meta lo mantiene open source como toda la familia SAM, y aquí está el repositorio de SAM 3 por si lo necesitas, y aquí el paper. Para que no digas luego que la IA solo vale para hacer videos falsos y pedir consejo a ChatGPT.

Y ahora vamos con la sección de HistorIAs de la IA de hoy. Ya dijimos la semana pasada que traeríamos al cerebro detrás de Deepmind, la parte de Google que lleva años dejándonos asombrados con las creaciones que hace. Gemini, Alphafold, AlphaGo, Genie, Nanobanana… una lista interminable de herramientas que si no están cambiando ya el mundo, lo harán pronto.

HistorIAs de la IA. Hoy: 👤 Quién es quién 👤

Sir Demis Hassabis: Del ajedrez y los videojuegos al Nobel, pasando por resolver el plegamiento de proteínas

Sir Demis Hassabis tiene 49 años. Es CEO de Google DeepMind desde 2024 (antes CEO de DeepMind antes de la fusión con Google Brain). Y no es un CEO cualquiera. Es de esos pocos científicos elegidos que han ganado un Premio Nobel. En su caso, el de Química 2024 por crear AlphaFold, la IA que resolvió uno de los problemas más difíciles de la biología: predecir cómo se pliegan las proteínas. Pero su historia es mucho más fascinante que ese Nobel, si es que eso se puede.

Nació el 27 de julio de 1976 en Londres, hijo de un profesor de química grecochipriota y una profesora de chino singapurense. A los 4 años jugaba al ajedrez. A los 8 ya era campeón de ajedrez infantil del Reino Unido. A los 13 ganó el campeonato nacional absoluto juvenil. Podría haber sido gran maestro, pero decidió que el ajedrez era solo el comienzo.

A los 17 años, en lugar de ir a la universidad, se fue a trabajar a Bullfrog Productions, la legendaria compañía de videojuegos. ¿No te suena Bullfrog Productions? Espérate, que si te gustan los videojuegos, a lo mejor sí que te suena… son los creadores de juegos míticos como Theme Park, Theme Hospital o Dungeon Keeper. De hecho, allí co-diseñó Theme Park, uno de los simuladores más exitosos de los 90. Pero Hassabis no estaba interesado solo en hacer juegos divertidos. Le fascinaba crear mundos donde las IAs actuaran de forma creíble. Sus NPCs (personajes no jugables) tenían comportamientos emergentes, tomaban decisiones que sorprendían incluso a los desarrolladores.

Con 20 años, fundó Elixir Studios y creó Republic: The Revolution, un juego de estrategia política con una IA tan compleja que algunas reviews dijeron que era "demasiado inteligente para su propio bien". El juego no fue un éxito comercial, pero llamó la atención de la comunidad académica porque la IA no era algo habitual en los videojuegos de la época: este tipo claramente sabía hacer que las máquinas pensaran.

Entonces hizo algo poco común: volvió a la universidad. A los 28 años se doctoró en Neurociencia Cognitiva en University College London. Su tesis: cómo el cerebro construye la memoria episódica y la imaginación. Publicó papers en Nature y Science (casi nada) sobre cómo el hipocampo crea simulaciones mentales del futuro. No era un informático jugando a hacer neurociencia, era un neurocientífico de verdad.

En 2010, con 34 años, fundó DeepMind con Shane Legg y Mustafa Suleyman. La misión: resolver la inteligencia y usarla para resolver todo lo demás (casi nada, otra vez). Su primer gran logro fue DQN (Deep Q-Network), una IA que aprendió a jugar 49 juegos de Atari sin que nadie le dijera las reglas. Solo mirando la pantalla.

Un joven Hassabis, junto a dos de sus pasiones: videojuegos y ajedrez.

Luego vino AlphaGo (2016). La IA que venció a Lee Sedol, el mejor jugador de Go del mundo. El Go es infinitamente más complejo que el ajedrez (más posiciones posibles que átomos en el universo). Y AlphaGo no solo ganó, jugó movimientos que los expertos consideraron "creativos" y "hermosos". Hassabis lloró durante la partida. Era la confirmación de que sus ideas funcionaban. Prácticamente la historia de cada párrafo da para una película, y la prueba de ello es que de hecho, la historia sobre AlphaGo está en una película (muy bien valorada) que puedes ver en Youtube , aquí. Si un día no tienes nada que ver, te la recomiendo.

En 2014, Google compró DeepMind por 500 millones de dólares. Pero Hassabis negoció algo inusual: autonomía total. DeepMind seguiría siendo DeepMind, con su propia cultura, sus propios objetivos. Y Google, a su crédito, respetó el acuerdo.

Entonces llegó AlphaFold (2020). El problema del plegamiento de proteínas había atormentado a los biólogos durante 50 años. Una proteína es una cadena de aminoácidos, pero su función depende de cómo se pliega en 3D. Predecir esa estructura había sido imposible. AlphaFold lo resolvió. No de forma aproximada, sino con precisión atómica. La comunidad científica lo llamó "el avance más importante de la biología del siglo XXI".

AlphaFold ha sido usado para diseñar nuevos medicamentos, entender enfermedades raras, desarrollar vacunas, ha ayudado a predecir estructuras de proteínas en las que otros métodos llevaban atascados una década… El avance es tan revolucionario que Hassabis ganó el Nobel de Química 2024 junto a John Jumper (quien lideró técnicamente el proyecto).

Sir Demis Hassabis, Nobel de Química de 2024, y una de las mentes más influyentes de todo el siglo XXI.

Pero Hassabis no se ha detenido ahí. Bajo su liderazgo, DeepMind creó:

AlphaCode: IA que compite en competiciones de programación

Gemini: la familia de modelos que rivalizan con GPT, ¿os suena?

AlphaFold 3: que ahora predice interacciones entre proteínas, ADN, ARN...

AlphaProof y AlphaGeometry: IAs que resuelven problemas de matemáticas olímpicas

Genie 3: Modelos que crean mundos 3D persistentes al instante.

En 2024, Google fusionó DeepMind y Google Brain en una sola entidad: Google DeepMind, con Hassabis como CEO. Es el científico que lidera el proyecto de IA más ambicioso de una de las empresas más poderosas del planeta.

¿Qué hace especial a Hassabis?

Que no es solo un empresario ni solo un científico. Es alguien que entiende profundamente qué es la inteligencia (gracias a su doctorado en neurociencia), cómo construirla (gracias a su experiencia en IA), y cómo desplegarla para resolver problemas reales (gracias a sus décadas en tecnología). Y lo hace con una humildad poco común en Silicon Valley. En entrevistas, suele decir que DeepMind "aún está en el acto uno de la obra". Que apenas están empezando. Que lo mejor está por venir.

Si Sundar Pichai es el gestor que orquesta Google, Demis Hassabis es el visionario que define hacia dónde va. Y si esta semana Google está celebrando Gemini 3 y Nano Banana Pro, gran parte del mérito es de este tipo que a los 4 años jugaba ajedrez y soñaba con construir mentes artificiales, y que ha dicho varias veces que cuando se retire y tenga un poco de tiempo quiere aplicar su conocimiento de IA para esta vez sí, hacer los mejores videojuegos.

Y para cerrar la newsletter, la herramienta que Google también lanzó esta semana pasada junto con Gemini 3 pro (sí, han estado muy ocupados): Antigravity. Si AI Studio es donde juegas con Gemini, Antigravity es donde Gemini trabaja por ti. Es un entorno de desarrollo (IDE) donde los agentes de IA planifican, escriben y ejecutan código de forma autónoma.

🛠 La Herramienta de la semana

Antigravity: El nuevo IDE de Google donde la IA programa por ti (literalmente)

Un IDE es un entorno de desarrollo, es decir, muy simplificado, “un programa con el que se programa”. Para los que sabéis qué es un IDE, Antigravity es el nuevo VS Code, o Cursor, o Windsurf… pero con más cosas. De hecho, Antigravity es un fork de VSCode (y tanto estéticamente como gran parte del funcionamiento, los perfiles, los atajos, etc, están sacados de VS Code, o, siendo precisos, de Windsurf, que a su vez es otro fork de VS Code)

Pero vale ya de decir “VS Code” cada cinco palabras. ¿Qué tiene de especial Antigravity (que no tenga VS Code 😅 )? Pues varios componentes clave, y muy interesantes:

1. El concepto "Agent-First" vs. "Editor-First"

VS Code es un editor de texto donde tú eres el protagonista y la IA es tu copiloto (te sugiere, te ayuda). Antigravity es una plataforma de gestión de agentes.

Su interfaz está dividida. Tienes el editor de código (que de hecho es un fork de VS Code, por lo que te resultará familiar), pero la novedad es el "Agent Manager" (o Mission Control).

En lugar de solo escribir código, tú asignas "misiones" o tareas complejas a agentes autónomos. No es un chat al que le pides una función; es un gestor al que le dices "Refactoriza este módulo y crea los tests", y el agente se va a trabajar en segundo plano.

2. Agentes Autónomos Reales (Planificación y Ejecución)

En VS Code, las extensiones de IA suelen ser reactivas (esperan a que escribas o preguntes). Es decir, los agentes pueden:

Planificar: Crean una lista de pasos antes de tocar nada.

Usar la Terminal: Ejecutan comandos, instalan dependencias y corren scripts por su cuenta.

Usar el Navegador: Tienen un navegador integrado para ver la web que están creando, "ver" el error visualmente y corregirlo. Sí, el propio agente se abre el navegador y se pone a hacer click a ver si todo funciona.

Verificar: No solo escriben el código, sino que ejecutan los tests para asegurar que funciona antes de avisarte.

3. Orquestación Multi-Agente Asíncrona

VS Code: Generalmente trabajas en una sola cosa a la vez. Si la IA está escribiendo, tú miras.

Antigravity: Puedes tener múltiples agentes trabajando en paralelo.

Ejemplo: Puedes poner a un agente a migrar una base de datos, a otro a actualizar el CSS de la home, mientras tú revisas código en el editor principal. Es como pasar de ser un albañil a ser el jefe de obra.

La manera de interactuar con varios agentes es única, y muy novedosa. Les puedes mandar tareas en paralelo, y ya ellos te enviarán mensajes que irán a una bandeja de entrada (o Inbox) cuando necesiten pedirte algún permiso o decirte si han acabado. Es como orquestar tu pequeño grupo de programadores y que se comuniquen contigo por email cuando te necesiten, en lugar de hablar con uno y quedarte mirándole hasta que acabe algo para pedirle lo siguiente.

De momento, parece que Google ha apostado fuerte por esta nueva manera de entender la programación con IA: si VS Code es la herramienta perfecta para escribir código, Google Antigravity quiere ser la herramienta perfecta para construir software delegando el trabajo sucio. Veremos cuánta gente lo empieza a usar. De momento, parece que mucha gente al menos la está probando por otra de sus grandes ventajas actuales: puedes usar como modelos, Gemini 3 Pro Thinking, Gemini 3 Pro, Claude Sonnet 4.5 y GPT OSS 120B (el modelo open source de OpenAI) de manera gratuita. Y eso no está nada mal.

Y hasta aquí la entrega #13 de la Newsletter.

Aquí cerramos otra semana, que ha traído tantas o más novedades que la anterior. Nano Banana Pro, Codex, Opus 4.5, Segment Anything… son modelos que estarán con nosotros los próximos meses (hasta que salgan otros mejores), y de los que seguiremos leyendo noticias, pero probablemente no veremos una explosión así de avances hasta el 2026… ¡veremos si nos dejan descansar un poco y disfrutar de lo que han creado!

Nos vemos la próxima semana. Y que alguien le diga a Google que se tome un respiro, que esto de lanzar tres productos en una semana nos tiene agotados.

Como siempre, recuerda que puedes puntuar el post y comentar después, por si quieres dar ideas, quejas, sugerencias, peticiones… 🤓 .

🧠 🧠 🧠 🧠 🧠 ¡Alimento para la mente!

🧠 🧠 🧠 Tienes que pensarlo mejor

🧠 Han faltado neuronas

Y si quieres que tus amigos o familiares estén tan al día de la IA como tú, ¡puedes compartirles esta newsletter o mi blog sobre IA! Uno con contenido de actualidad, y otro con artículos más elaborados, que te ayudarán a entender la IA desde otro punto de vista.

>>> Nos vemos en la siguiente entrega 🤝

>>> ¡ Hasta prompto !