Bienvenido al Prompt, la newsletter sobre Inteligencia Artificial escrita con un poco de Inteligencia Natural

¡Hola prompters! 13 de Noviembre. Undécima entrega y aquí seguimos 🚀, viendo cómo esta semana China nos ha recordado que también allí investigan mucho y muy bien y no hay quien les pare, mientras OpenAI protagonizaba un pequeño drama corporativo sobre si quieren que el gobierno les rescate o no (spoiler: no quieren, pero las palabras importan), y una de las científicas más influyentes de la IA nos explicaba por qué todo lo que hemos conseguido hasta ahora... es solo el principio. La científica en cuestión es Fei-Fei Li, y si quieres conocerla más a fondo, hoy hablamos de ella en historIAs de la IA. Y en nuestra última sección, hoy vuelve “el Metaprompt” un consejo para que saques mayor partido a Gemini.

>>> Tres noticias destacadas

🇨🇳 Kimi K2 Thinking: El modelo open source chino que destrona a GPT-5 en los benchmarks más difíciles

💵 OpenAI y el "rescate gubernamental": Cuando una palabra mal usada te obliga a que salga el CEO, a desmentir

🌍 Fei-Fei Li y la Inteligencia Espacial: Por qué la próxima revolución de la IA no son chatbots más listos, sino máquinas que entienden el mundo físico

>>> HistorIAs de la IA

👤 Quién es quién 👤: Fei-Fei Li, la "madrina de la Computer Vision" que construyó ImageNet y ahora quiere que la IA piense en 3D.

>>> El Metaprompt

🎨 Gemini hace presentaciones: Cómo crear diapositivas decentes con un solo prompt.

Y por aquí abajo está la canción resumen de la semana. Esta semana con toques chinos (un poquito de erhu, un toque de dizi, algo de guzheng…) en honor a Kimi K2, y a nuestro perfil de la semana y su ensayo.

¿Qué ha pasado esta semana en el mundo de la IA?

El pasado 5 de noviembre, Moonshot AI (una startup china respaldada por Alibaba) lanzó Kimi K2 Thinking, y la reacción en la comunidad de IA fue explosiva. No es para menos: es un modelo de razonamiento open source que supera a GPT-5 y Claude Sonnet 4.5 en varios benchmarks clave, es más eficiente, y trae consigo una novedad que otros modelos no tienen. Más abajo verás el truco.

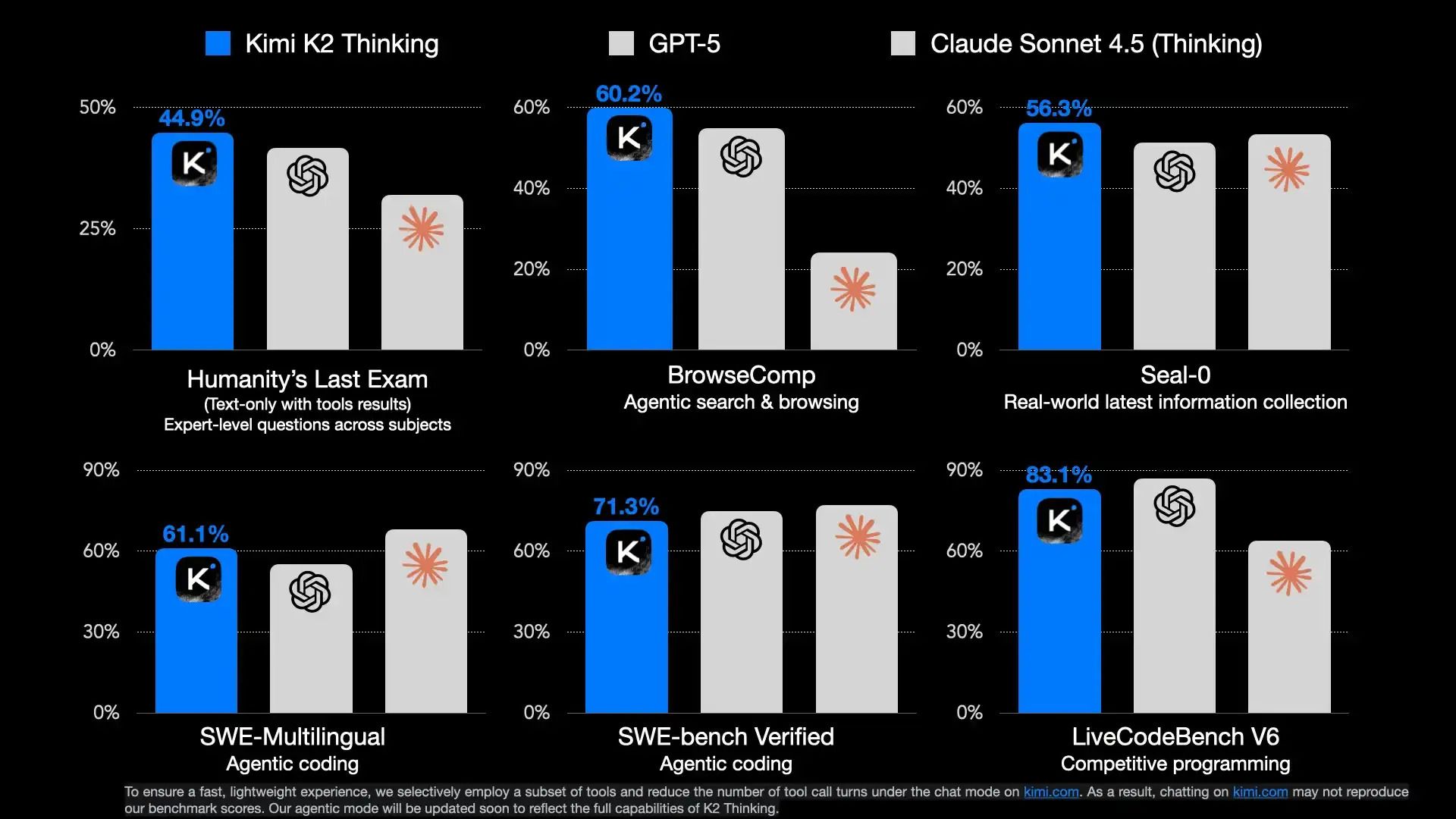

Kimi K2 Thinking es un modelo MoE (Mixture of Experts) con 1 billón de parámetros totales, de los cuales 32 mil millones se activan por token. Ventana de contexto de 256K tokens. Con esto, ha sacado una puntuación en uno de los tests más difíciles que existen ahora mismo (el HLE o Humanity´s Last Exam del que ya hemos hablado en anteriores posts) del 44.9 %. Este benchmark, creado por el Center for AI Safety, consiste en miles de preguntas académicas difíciles en múltiples disciplinas. Y en este benchmark, algunas superestrellas como GPT-5 y Claude Sonnet 4.5 se quedan por debajo.

Kimi 2 Thinking está, cuanto menos, al nivel de gigantes como GPT-5 o Claude 4.5

El truco: "Interleaved Reasoning" (o razonamiento intercalado)

Aquí está la innovación técnica clave. La mayoría de los modelos de razonamiento (como o3 de OpenAI o los thinking models de DeepSeek) funcionan así: piensa → actúa → termina. De esta forma, si le pides que te digaK2 Thinking hace algo diferente: piensa → actúa → piensa → actúa → piensa → actúa... hasta 200-300 veces seguidas sin perder el hilo.

Es como resolver un problema de matemáticas complejo. No lo haces de un tirón. Piensas un poco, haces un cálculo, miras el resultado, piensas más, ajustas, vuelves a calcular... K2 Thinking hace exactamente eso, pero con herramientas: puede buscar en internet, ejecutar código Python, leer documentación, y en cada paso reevalúa su estrategia.

El término técnico es "interleaved reasoning" (razonamiento entrelazado). Es algo que no es completamente nuevo, no son los desarrolladores del concepto, pero parece que sí son los primeros en maximizar su utilidad. Moonshot AI reporta que K2 resolvió un problema de geometría hiperbólica a nivel de doctorado ejecutando 23 pasos intercalados de razonamiento y uso de herramientas. No es magia, es persistencia computacional.

Lo mejor: es de código abierto, eficiente y más barato

El modelo es open source (bueno, casi). Usa una licencia tipo MIT modificada: puedes usarlo libremente, salvo que si tu producto tiene más de 100 millones de usuarios activos mensuales O más de $20M de ingresos mensuales, tienes que mostrar el branding de Kimi K2 en tu interfaz. Es una jugada inteligente: democratiza el acceso mientras obliga a los gigantes a darles crédito. Pero además, pese a ser un gigante de 1 billón de parámetros, tiene cuantización INT4. ¿Qué significa este palabro? Que pese a lo grande que es, está comprimido, sin apenas perder calidad, en núermos enterosd e 4 bits, cuando lo típico suele ser INT8, lo que hace que el modelo pese la mitad, sea más eficiente, y más barato de usar.

¿Por qué importa otra noticia más sobre otro modelo más que ha batido no-se-cual benchmark?

Porque demuestra tres cosas:

China no está atrasada en IA: Y cada vez enseña más resultados interesantes en eficiencia y modelos abiertos.

El open source puede competir con modelos cerrados: La brecha se está cerrando rapidísimo.

La investigación de nuevas arquitecturas no está estancada. Hacer más grandes, más pesados, con entrenamientos más potentes y datasets gigantescos es parte del proceso. Pero tambien desarrollar novedades como el “interleaved reasoning”

Los modelos abiertos (en azul) cda vez están más cerca de los propietarios (naranja). O al menos así era hasta el informe de Epoch.AI de hace un año, donde mostraron esta gráfica.

Si quieres conocer un poco mejor Kimi K2, aquí tienes su página de github , su paper de arXiv, y algunos detalles técnicos más. Y si eres de los que prefieren pasar a probarlo directamente, puede hacerlo aquí aunque habrá que esperar a poder usarlo de forma gratuita porque parece que de momento solo tienen gratis los modelos 1.5 y 2.

Ahora un poquito de drama, confusiones, y correcciones de Sam Altman a su CFO por lo que dijo en una entrevista con Wall Street Journal el dia anterior. Lo típico de que sale un portavor y dice algo y se lía y tiene que salir el ministro a desmentir, en versión IA:

💸 OpenAI y el "rescate gubernamental" que nunca fue (pero casi)

Esta semana OpenAI protagonizó uno de esos episodios corporativos donde una sola palabra mal elegida desencadena un caos mediático que obliga al CEO, al CFO y hasta al "zar de la IA" del presidente Trump a salir a dar explicaciones. Todo empezó el miércoles 6 de noviembre en un panel del Wall Street Journal.

Lo que dijo Sarah Friar (CFO de OpenAI)

Durante el evento Tech Live, Friar habló sobre cómo OpenAI planea financiar su milmillorania expansión de infraestructura. La empresa ha comprometido $1.4 billones ($1.4T para los americanos) en datacenters y chips. Friar comentó que están buscando un "ecosistema" de financiación: bancos, fondos de private equity, y... usó la palabra "backstop".

En cristiano: un "backstop" es cuando el gobierno garantiza un préstamo. Si la empresa no puede pagar, los contribuyentes asumen la deuda. Es como cuando tus padres co-firman tu préstamo estudiantil. Si tú no pagas, ellos pagan. Pero aquí estamos hablando de cantidades con muchos ceros.

La reacción fue inmediata

Twitter (perdón, X) explotó. "¿OpenAI quiere un rescate con dinero de los contribuyentes?" "¿Una empresa valuada en $500 mil millones pidiendo garantías gubernamentales?" "¿Se está conviertiendo OpenAI en una empresa “too big to fall” (demasiado grande como para caer)?" .

David Sacks, el "zar de la IA" de Trump (no es que me haya puesto creativo, es que le conocen así), fue el primero en salir al paso:

"No habrá rescate federal para la IA. EEUU tiene al menos 5 empresas de modelos de frontera [LLMs como GPT, Gemini, Claude, Grok….] Si una falla, otras tomarán su lugar."

Traducción: el gobierno no va a rescatar a OpenAI.

Friar se retracta (rápido)

Ese mismo miércoles por la noche, Sarah Friar publicó en LinkedIn:

"OpenAI no está buscando un respaldo gubernamental para nuestros compromisos de infraestructura. Usé la palabra 'backstop' y enturbió el mensaje. Como muestra el clip completo de mi respuesta, estaba haciendo el punto de que la fortaleza tecnológica de América vendrá de construir capacidad industrial real, lo cual requiere que el sector privado y el gobierno jueguen su parte."

Traducción: "Metí la pata con una palabra, pero no estamos pidiendo un rescate."

Sam Altman sale a aclarar (más)

Al día siguiente, jueves 7 de noviembre, Sam Altman publicó un hilo largo en X. Los puntos clave:

No queremos garantías gubernamentales: "No tenemos ni queremos garantías del gobierno para los datacenters de OpenAI. Creemos que los gobiernos no deberían elegir ganadores o perdedores, y que los contribuyentes no deberían rescatar empresas que toman malas decisiones de negocio."

Si nos equivocamos, que nos vaya mal: "Si metemos la pata y no podemos arreglarlo, deberíamos fallar, y otras empresas continuarán haciendo buen trabajo. Así funciona el capitalismo."

Estamos creciendo: "Esperamos cerrar este año con $20 mil millones en ingresos anualizados y crecer a cientos de miles de millones para 2030." (Nótese el plural: cientos de miles de millones).

El único backstop que hemos discutido es para fábricas de chips: "El único área donde hemos discutido garantías de préstamos es para apoyar la construcción de fábricas de semiconductores en EEUU, donde respondimos al llamado del gobierno."

¿Qué pasó realmente?

Lo más probable es que Friar estaba hablando en general sobre el rol del gobierno en infraestructura crítica (energía, permisos, facilitación), y usó "backstop" pensando en "apoyo estructural", pero en el contexto financiero esa palabra tiene un significado muy específico: garantía de deuda.

Todo apunta a que fue un error de comunicación amplificado por el momento: OpenAI está bajo escrutinio constante por sus gastos masivos, su reestructuración corporativa polémica, y las dudas sobre cómo van a pagar todo lo que están prometiendo.

¿Por qué importa?

Porque revela la tensión subyacente en la carrera de la IA: las empresas necesitan inversiones colosales (miles de millones de dólares en infraestructura) para competir con China, pero el público y el gobierno no están dispuestos a socializar el riesgo. OpenAI está en una posición incómoda: necesita capital masivo, tiene una valuación estratosférica, pero aún no es rentable. Y cada palabra que dicen sus ejecutivos es analizada con lupa.

La buena noticia para Altman es que esta vez actuaron rápido. Hace dos años, cuando lo despidieron del board, tardaron días en reaccionar. Esta vez, en menos de 24 horas ya tenían a todo el mundo alineado en el mensaje. Deber de tener el móvil con Twitter abierto siempre al lado, por si se lía alguna como la que se ha montado esta semana

Y ahora, un manifiesto de una de las investigadoras a las que hay que agradecer lo avanzada que está la IA en 2025, y a la que al menos hay que escuchar, por ello:

🌍 Fei-Fei Li: "La IA necesita entender el espacio, no solo las palabras"

El 11 de noviembre, Fei-Fei Li publicó un ensayo titulado "From Words to Worlds: Spatial Intelligence is AI's Next Frontier" (De palabras a mundos: La inteligencia espacial es la próxima frontera de la IA). Aquí la palabra espacial no se refiere al espacio exterior, que llevamos una semanas que si satélites y GPUs puestos en órbita, sino al espacio geométrico, al entorno físico que nos rodea.

Fei-Fei, cofundadora y CEO de World Labs (¡más abajo te explico su historia!), argumenta que hemos llegado al límite de lo que la IA basada en lenguaje puede hacer. Los LLMs son increíbles para procesar texto, pero son "wordsmith in the dark" (maestros de las palabras en la oscuridad): elocuentes pero sin experiencia, conocedores pero desconectados de la realidad física.

¿Qué es la Inteligencia Espacial?

Es la capacidad de entender, razonar, y actuar en el mundo tridimensional. Es lo que usas cuando (usando los ejemplos de su ensayo):

Estacionas un coche imaginando el espacio que queda entre el parachoques y el bordillo

Atrapas unas llaves que te lanzan desde el otro lado de la habitación

Caminas por una acera llena de gente sin chocar con nadie

Un bombero se mueve por un edificio en llamas tomando decisiones sobre estabilidad y supervivencia basándose en señales visuales y físicas

Todo esto lo hacemos de forma intuitiva, automática (aunque algunos somos peores en ello y nos chocamos con el pico de la mesa). Las máquinas, no.

Fei-Fei argumenta que la inteligencia espacial no es solo un "nice to have", algo que "estaría bien tener”. Es el andamiaje sobre el que se construyó la cognición humana. La percepción y la acción fueron el loop evolutivo que nos llevó de organismos simples a... bueno, a nosotros.

Por qué los LLMs actuales no lo tienen

Los modelos multimodales actuales (como GPT-5, Claude Sonnet 4.5, Gemini 2.5) pueden analizar imágenes y responder preguntas sobre ellas. Pero:

Rara vez superan el azar estimando distancia, orientación, o tamaño

No pueden "rotar mentalmente" objetos regenerándolos desde nuevos ángulos

No pueden navegar laberintos, reconocer atajos, o predecir física básica

Los videos generados por IA pierden coherencia después de pocos segundos

Son buenos leyendo el mundo, pésimos entendiéndolo espacialmente. Y aunque podemos darles todo el internet para que aprendan a predecir la próxima palabra, hay situaciones que no van a aprender nunca si no son capaces de simular entornos realistas de lo que se pueden encontrar. Pone por ejemplo un nanobot, que podría ser creados para inyectarse en humanos y realizar tareas complejas, pero no sabrá navegar el cuerpo humano autónomamente por IA si no se enseña al nanobot a entender su entorno, o se simula con ayuda de este conocimiento espacial.

La solución en la que está trabajando: World Models

Li propone una nueva clase de modelos generativos llamados "world models" (modelos de mundo), que deben tener tres capacidades esenciales:

Generativos: Pueden generar mundos con consistencia perceptual, geométrica y física. No solo imágenes bonitas, sino espacios que obedecen las leyes de la geometría, la física, y la dinámica.

Multimodales por diseño: Deben procesar entradas diversas (imágenes, videos, mapas de profundidad, texto, gestos, acciones) y predecir o generar estados del mundo tan completos como sea posible.

Interactivos: Si reciben una acción o un objetivo como entrada, deben producir el siguiente estado del mundo consistente con el estado anterior, las leyes físicas, y los comportamientos dinámicos.

Es ambicioso, y Fei-Fei no cree que lo vaya a conseguir un investigador, o una sola empresa, sino que será el resultado de mucho esfuerzo colectivo. Pero cree que es el único camino hacia robots domésticos reales, hacia simulaciones científicas precisas, hacia creatividad inmersiva, y hacia IA que realmente entienda el mundo físico. Según dice,

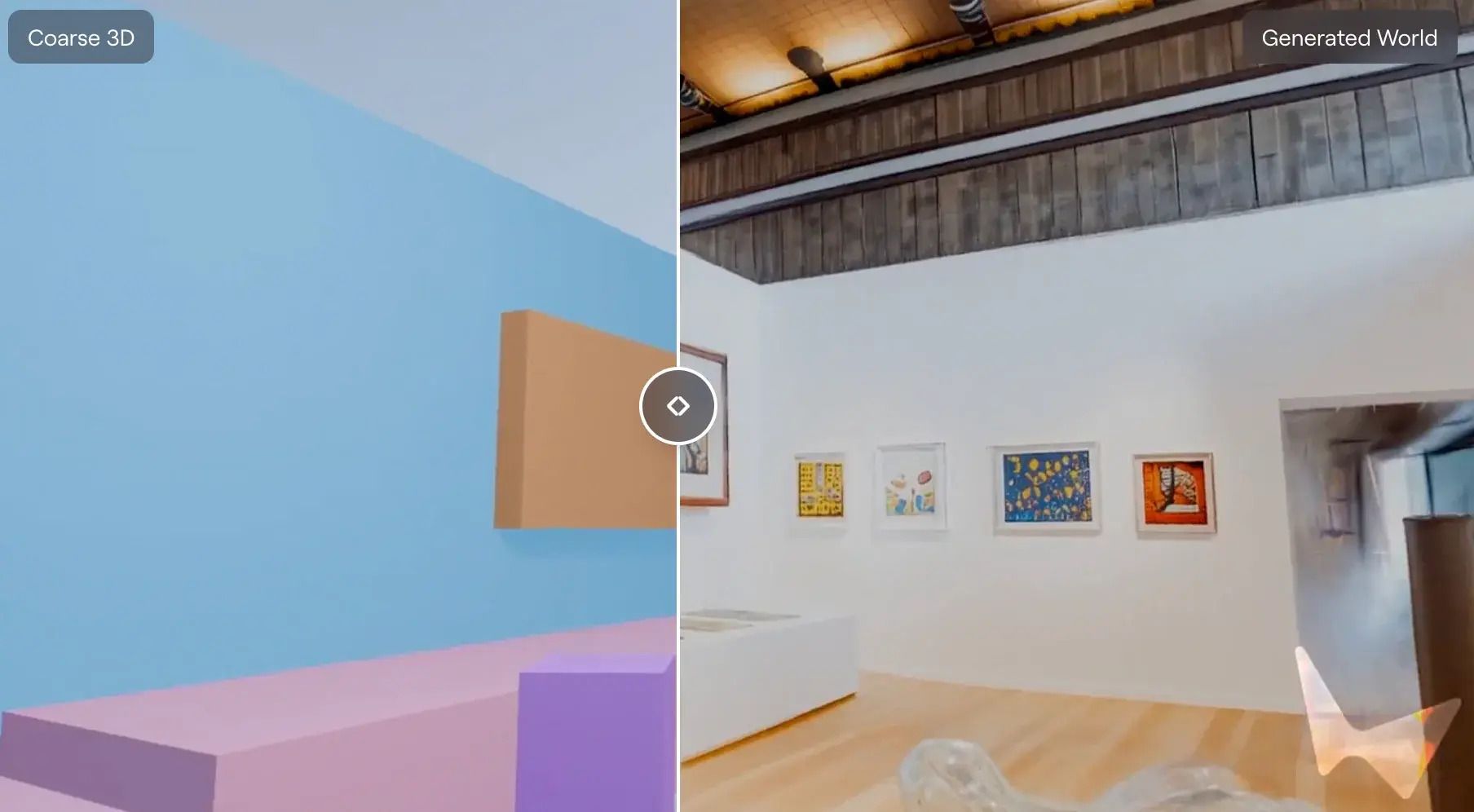

Marble: el primer vistazo

World Labs acaba de compartir con usuarios limitados una demo de Marble, su primer world model. Puedes darle inputs multimodales (texto, imágenes, descripciones) y genera entornos 3D consistentes que puedes explorar, con los que puedes interactuar, y sobre los que puedes construir.

Un ejemplo de un entorno que crea con el prompt “un bonito museo de arte moderno con suelo de madera, lleno de cuadros coloridos y esculturas curvas”

No es perfecto. Está lejos de serlo, (y lejos de otras alternativas como la alucinante Genie 3, de Deepmind, de la que hablaré en otra ocasión). Pero es un primer paso necesario hacia un modelo que no solo genera imágenes bonitas, sino que entiende que los objetos tienen volumen, que la gravedad existe, y que si te mueves por un espacio, las cosas deberían verse diferentes desde otro ángulo.

¿Por qué importa?

Porque si Li tiene razón, la próxima década de IA no será sobre chatbots más listos. Será sobre máquinas que puedan:

Navegar tu casa y ayudarte físicamente

Diseñar edificios entendiendo estructuras espaciales

Acelerar descubrimientos en ciencia de materiales y medicina simulando mundos físicos

Crear experiencias inmersivas en educación, entretenimiento y creatividad

Y todo esto requiere que la IA salga de su caja de texto y aprenda a ver, tocar, y moverse por el mundo como lo hacemos nosotros.

Como dijo Wittgenstein: "Los límites de mi lenguaje son los límites de mi mundo." Para la IA, el lenguaje ya no es suficiente. El mundo físico la está esperando.

Y hoy, en HistorIAs de la IA conoceremos la historia de la autora del ensayo anterior: Fei-Fei Li, una de las científicas más influyentes en la IA, y la visión artificial.

HistorIAs de la IA. Hoy: 👤 Quién es quién 👤

Fei-Fei Li: La científica que enseñó a las máquinas a ver (y ahora quiere que entiendan el espacio)

Si tuvieras que elegir a una persona responsable de que la IA moderna pueda reconocer gatos en fotos, esa persona sería Fei-Fei Li. Y su historia es de esas que te hacen pensar que a veces el timing y la persistencia son más importantes que el genio puro.

De China a Nueva Jersey, con una tintorería de por medio

Fei-Fei Li nació en Pekín en 1976. A los 16 años emigró con su familia a New Jersey. Sus padres, ambos con educación universitaria en China, tuvieron que reinventarse: su madre trabajaba de cajera, su padre montó una pequeña tintorería. Li pasaba las tardes después de la escuela ayudando en el negocio, planchando camisas y atendiendo clientes mientras soñaba con estudiar física.

Entró a Princeton (con beca, obviamente), se graduó en física, y luego hizo un doctorado en Caltech en Ingeniería Eléctrica con especialización en Neurociencia Computacional. Su tesis, dedicada a sus padres: cómo las neuronas procesan información visual. Ya desde entonces estaba obsesionada con una pregunta: ¿cómo vemos?

Fei-Fei, es una voz consistente sobre la ética en IA, sobre diversidad en el mundo de la tecnología, y sobre cómo la IA debería servir a la humanidad, no al revés. Pero también es una de las mejores investigadoras científicas del mundo, avalado por números. Tiene un índice H de 156 (para los no académicos: eso significa que tiene al menos 156 papers con al menos 156 citas cada uno, algo al alcance de muy pocos).

ImageNet: el dataset que cambió todo

En 2006, Li llegó a Stanford como profesora asistente. La visión artificial estaba estancada. Los modelos funcionaban bien en laboratorio con datasets pequeños y controlados, pero en el mundo real... no tanto. Li tuvo una intuición: el problema no eran los algoritmos, era la falta de datos.

Así nació ImageNet. Entre 2007 y 2009, Li y su equipo construyeron un dataset de 14 millones de imágenes etiquetadas manualmente (sí, a mano) en 20,000 categorías. Usaron Amazon Mechanical Turk para escalar el etiquetado. Fue un trabajo monumental, casi ridículo en su ambición.

En 2012 pasó algo histórico: en el ImageNet Large Scale Visual Recognition Challenge (ILSVRC), un equipo liderado por Geoffrey Hinton y Alex Krizhevsky usó una red neuronal convolucional profunda (AlexNet) y arrasó con la competencia. Error top-5 de 15.3%, casi la mitad del segundo lugar.

Ese fue el momento "big bang" del deep learning moderno. Y todo empezó porque Fei-Fei y sus compañeros construyeron el dataset que hizo posible entrenar esos modelos.

De académica a CEO (con un parón en Google)

Li pasó dos años en Google (2017-2018) como VP y Chief Scientist de AI/ML en Google Cloud. Fue una etapa complicada: estuvo involucrada en el controvertido proyecto Maven (usar IA de Google para analizar videos de drones militares), que generó protestas internas masivas y al final provocaron que Google no renovara el contrato con el Pentágono. Li dejó Google y volvió a Stanford.

Pero en 2023 fundó World Labs junto con Justin Johnson, Christoph Lassner, y Ben Mildenhall. La misión: construir modelos de mundo (en analogía con los actuales LLMs o modelos de lenguaje) que entiendan el espacio físico, no solo el lenguaje. En menos de dos años, World Labs consiguió una valuación de $12 mil millones.

¿Por qué importa Fei-Fei Li?

Porque es una de las pocas personas en IA que ha tenido impacto en múltiples niveles:

Infraestructura: ImageNet es uno de los tres pilares del deep learning moderno (junto con las redes neuronales y las GPUs).

Academia: Su grupo de investigación en Stanford ha producido docenas de PhDs que ahora lideran equipos en todas las grandes empresas de IA.

Industria: Como muchos otros grandes investigadores de IA del momento, se está lanzando a reflejar su visión de la IA en productos tangibles a través de start-up que ellos mismos crean. En el caso de Fei-Fei, World Labs, que está por próxima frontera de modelos de mundo con inteligencia espacial.

Por cierto, antes mencionaba el grupo de investigación de Fei-Fei Li en Stanford. Stanford es una de las universidades de referencia en IA junto con otras como Harvard, Carnegie Mellon o Berkeley. De ellas salen y han salido decenas de genios que están dando forma a la frontera del conocimiento en la IA. Pero no son los únicos que tienen acceso al conocimiento que reciben por ser de esas universidades. Muchas de las clases y las charlas que reciben están en internet, gratis, para que cualquiera pueda acceder a ellas sin pagar una matrícula prohibitiva. En este link por ejemplo, dejo un pequeño compendio de las 16 clases de más de 1 hora cada una que el laboratorio de Visión Artificial de Stanford tiene en Youtube desde hace ya ocho años para que cualquiera aprenda. En el primer vídeo verás a la misma Fei-Fei Li dando la clase. El conocimiento está ahí, al alcance de todos, incluído de las IAs que han aprendido viendo estos mismos videos que hablan de cómo crear la propia tecnología con la que han sido creadas.

Para acabar, esta semana volvemos con la sección de El MetaPrompt (ya sabéis, una idea de un prompt útil que dejo aquí, en una newsletter que se llama >>> El Prompt 🙊 ). Esta vez vemos lo fácil que es hacer presentaciones powerpoint, con una simple petición

El Metaprompt

🎨 Cómo crear una presentación de diapositivas sin abrir PowerPoint, con tan sólo una frase

Google acaba de lanzar (o más bien, de terminar de desplegar) una funcionalidad en Gemini que muchos llevábamos esperando: crear presentaciones completas con un solo prompt. ¿Qué tal funciona? Regular, tirando a mal. O a lo mejor soy muy exigente. Pero hay esperanza, mejorará. Y a lo mejor ya le puedes encontrar un uso ahora mismo.

Cómo funciona

Ve a gemini.google.com

Abre "Canvas" desde la barra de herramientas

Escribe: "Crea una presentación sobre [tema]"

O sube un documento (PDF, Doc, lo que sea) y pide: "Convierte esto en una presentación"

Así se ve la interfaz de Gemini cuando le pides una presentación. Esto es una captura de mi propia conversación esta semana para probarlo. Pedí en una frase una presentación sobre nuestra conocida Fei-Fei Li, y me sacó esto en un par de minutos. Más abajo pongo el enlace a toda la presentación

Gemini genera slides con diseño, estructura, imágenes (a veces generadas por IA, a veces de búsqueda), y texto formateado. Luego puedes exportarlo directamente a Google Slides para seguir editando. O le puedes preguntar cosas concretas de la presentación pintando un recuadro sobre la parte que quieras.

Lo bueno

Es rápido: De idea a slides en menos de 2 minutos.

Entiende estructura: No te hace un bloque de texto interminable. Secciones, bullets, títulos claros.

Export directo a Slides: Nada de copiar-pegar. Un click y está en Google Slides.

Lo menos bueno

El diseño es... funcional: No esperes ganaste ningún premio de diseño. Es limpio, pero genérico.

Suele fallar en las imágenes, o se las inventa o te pone imágenes de stock que ni tienen que ver

A veces se pasa o se queda corto: O te hace 25 slides cuando pediste un resumen, o te hace 6 cuando querías profundidad.

Un ejemplo:

Para demostrar el movimiento andando, pedí a Gemini que me hiciera una presentación sobre Fei-Fei Li, como véis en la imagen de arriba. Usé el siguiente prompt:

Hola! Hazme una presentación sobre Fei-Fei Li, su creación de ImageNet y su trayectoria profesional desde entonces

El resultado lo podéis ver aquí en este enlace. Yo le daría un 3 sobre 10. No ya por las imágenes que intentó poner y no pudo, no sé si por error puntual o porque siempre es así de fallón con eso. Sino porque es una presentación muy básica, muy de “me la han puesto de deberes, tengo 20 minutos y me da tiempo a esto”.

A lo mejor soy demasiado exigente con las presentaciones, por llevar 25 años rodeados de ellas, y haciendo una casi cada mes. O a lo mejor un productor de música piensa lo mismo de la calidad de las canciones de Suno, o un programador que trabaje en Google piensa lo mismo del código que te da el autocompletado de Copilot. Juzgad vosotros mismos.

“Pero Carlos, ¿por qué nos recomiendas un prompt al que tú mismo le das un 3 de nota, ya te has quedado sin herramientas útiles de IA que recomendar?”

Lo traigo porque puede ser un recurso que pueda venir bien en alguna situación, y no es intuitivo saber que si le pides a Gemini, en modo Canvas, que te haga una prsentación, te dará algo tipo Powerpoint. Del resto, de la calidad de la presentación, ya se encargarán ellos en poco tiempo, y en cuestión de meses o años, veremos cómo herramientas como ésta, bien usadas, le “quitarán trabajo” a Powerpoint.

Es verdad que puedes trabajarlo un poco y ser más específico en tu petición, dar más contexto, tipo “Crea una presentación de 10 slides para una audiencia técnica sobre [tema]. Enfócate en [aspecto específico]. Usa un tono [formal/casual/educativo]. Incluye al menos 3 gráficos o diagramas." Cuanto más específico seas, mejor el output. O que puedes pedirle que se ciña a un estilo corporativo, por ejemplo dándole una plantilla de cómo son las presentaciones en tu grupo o empresa. Pero aun así, el resultado está lejos de lo que esperamos que haga la IA por ti.

Además, en esto Gemini ni son los primeros, ni los mejores. Esto no es nuevo. Gamma.app lleva años haciendo esto (y mejor, en mi opinión, ya lo traeré en una próxima entrega de la 🛠 Herramienta de la Semana 🛠 ). Aunque Gemini tiene una ventaja: la integración directa con Google Workspace. Si ya vives en Gmail, Docs, Drive... esto simplemente funciona sin fricción. Y podrás hacer presentaciones de información que vive en tu correo, o documentos que tienes en Google Drive, sin siquiera buscarlos y adjuntarlos. Y cuando Gemini haga las presentaciones mejor que un niño de 10 años, quizá sea mejor alternativa que una hiper-especializada Gamma.app.

Y hasta aquí la entrega #11 de la Newsletter.

Esta semana hemos visto cómo China sigue demostrando que la IA open source no es un ciudadano de segunda clase, cómo una palabra mal elegida puede desatar el caos corporativo incluso en la empresa de IA más valiosa del mundo, y cómo una de las mentes más brillantes del campo nos recuerda que aún nos queda un largo camino por recorrer. Y no os he hecho una presentación powerpoint de la newsletter porque sale regular, pero esperaos a la entrega #111 que ¡a lo mejor para entonces Gemini ya las hace como un pro!

Como siempre, recuerda que puedes puntuar el post y comentar después, por si quieres dar ideas, quejas, sugerencias, peticiones… 🤓 .

🧠 🧠 🧠 🧠 🧠 ¡Alimento para la mente!

🧠 🧠 🧠 Tienes que pensarlo mejor

🧠 Han faltado neuronas

Y si quieres que tus amigos o familiares estén tan al día de la IA como tú, ¡puedes compartirles esta newsletter o mi blog sobre IA! Uno con contenido de actualidad, y otro con artículos más elaborados, que te ayudarán a entender la IA desde otro punto de vista.

>>> Nos vemos en la siguiente entrega 🤝

>>> ¡ Hasta prompto !