Bienvenido al Prompt, la newsletter sobre Inteligencia Artificial escrita con un poco de Inteligencia Natural

¡Hola prompters! 6 de Noviembre. Primera entrega del mes, y décima de la historia de >>> El Prompt. ¿Llegaremos a los 20? ¿Y a los 100?. Vamos poco a poco. De momento esta semana traigo tres noticias muy novedosas y distintas entre si, que muestran que la IA siempre trae noticias por muchas avenidas distintas…: chips que usan el desorden como recurso computacional, un robot doméstico con teleoperador incluido (sí, alguien controlándolo en remoto por tu casa), y Google que también está estudiando seriamente poner en órbita sus chips.

Ah, y de perfil os traigo a Sam Altman CEO de OpenAI, que lleva dos años desde su despedida-relámpago y ahora está en medio de juicios varios.

>>> Tres noticias destacadas

💥 Extropic: Un nuevo diseño de procesador pensado para IA, y 10000 veces más eficiente

🦾 Robot Neo 1x: El robot que ya puedes comprar por $20k, con entrega en 2026 (y que apenas hace nada por sí solo, aún)

🛰 Google quiere poner sus chips de IA en órbita

>>> HistorIAs de la IA

👤 Quién es quién 👤 Sam Altman: El CEO que fue despedido (por 5 días) y ahora está en juicio.

>>> Una herramienta

🛠 Google Skills: Cursos y certificados de Google que pocos conocen (y que pueden serte útiles)

Y por aquí abajo está el la canción resumen de la semana. Esta semana, un hip-hop clásico, con sus scratches, sus 808 y a varias voces 🖖 .

¿Qué ha pasado esta semana en el mundo de la IA?

Vale, agárrate porque esto suena a ciencia ficción. ¿Recuerdas esas clases de física donde te enseñaban que el calor y el desorden (la entropía, para los frikis) son enemigos de la eficiencia? Pues Extropic, una startup que acaba de salir del modo sigilo, ha decidido usarlos como base de sus chips de IA. Literalmente.

El problema es el que todos están intentando solucionar ahora mismo: cada datacenter nuevo consume lo que una ciudad pequeña, y ya hay proyectos de IA que no pueden arrancar porque no encuentran dónde conectarse a la red eléctrica. OpenAI habla de necesitar "cientos de miles de millones" de dólares solo en infraestructura energética. No es sostenible. Saben que se necesita una revolución en eficiencia, no solo en producción de energía, sino quieren que se llegue a un límite insostenible.

Extropic ha diseñado un tipo de chip completamente nuevo: el Thermodynamic Sampling Unit (TSU). Su idea es que en vez de luchar contra el ruido y el calor que ocurren naturalmente en los circuitos electrónicos (como hacen las GPUs), los usan como aliado, como el motor de la computación.

Lo importante no es cómo se ve por fuera, sino cómo funciona por dentro.Pero no les ha quedado mal el packaging…

¿Cómo? No es nada fácil de explicar, y entenderlo y explicarlo bien llevaría mucho más que este post. Pero brevemente: con "p-bits" (bits probabilísticos) que fluctúan aleatoriamente entre 0 y 1 bajo influencia térmica. Mientras que un bit normal de tu ordenador es determinista (es 0 o es 1), un p-bit es probabilístico: tiene cierta probabilidad de ser 0 y cierta de ser 1, y va alternando entre estados. Conectas miles de estos p-bits en red, cada uno influenciado por sus vecinos, y el resultado es que puedes samplear (generar muestras) de distribuciones de probabilidad extremadamente complejas. Que es, básicamente, lo que hace la IA generativa.

Los modelos actuales (GPT, Gemini, Stable Diffusion) hacen toneladas de multiplicaciones de matrices en GPUs para calcular probabilidades, y luego samplear de ellas. Los TSUs se saltan toda esa parte y samplea directamente. Es como si en vez de calcular la ruta más rápida a un sitio haciendo matemáticas, simplemente dejaras que el agua fluya por todos los caminos y siguieras el que termine primero. La naturaleza encuentra la solución.

Han fabricado un prototipo funcional (XTR-0) que ya han probado con algunos colaboradores. Y han creado un nuevo tipo de algoritmo de IA llamado Denoising Thermodynamic Model (DTM), inspirado en los modelos de difusión, pero diseñado específicamente para aprovechar este hardware. Sus simulaciones muestran que podrían ser hasta 10,000 veces más eficientes energéticamente que las GPUs para tareas de IA generativa. Nada mal.

Ahora bien, la pregunta del millón: ¿escalará esto? Pasar de un prototipo con miles de p-bits a un procesador que compita con Nvidia es como pasar de hacer una tortilla a abrir un restaurante con tres estrellas Michelin. Pero bueno, con la IA chocando contra el "muro energético", no está mal que alguien piense diferente. Y Extropic lo está haciendo, literalmente desde los principios de la física.

Ahora una noticia de robots, que hacía tiempo que no hablábamos de robots. Ya puestos con estos avances de ciencia ficcións..

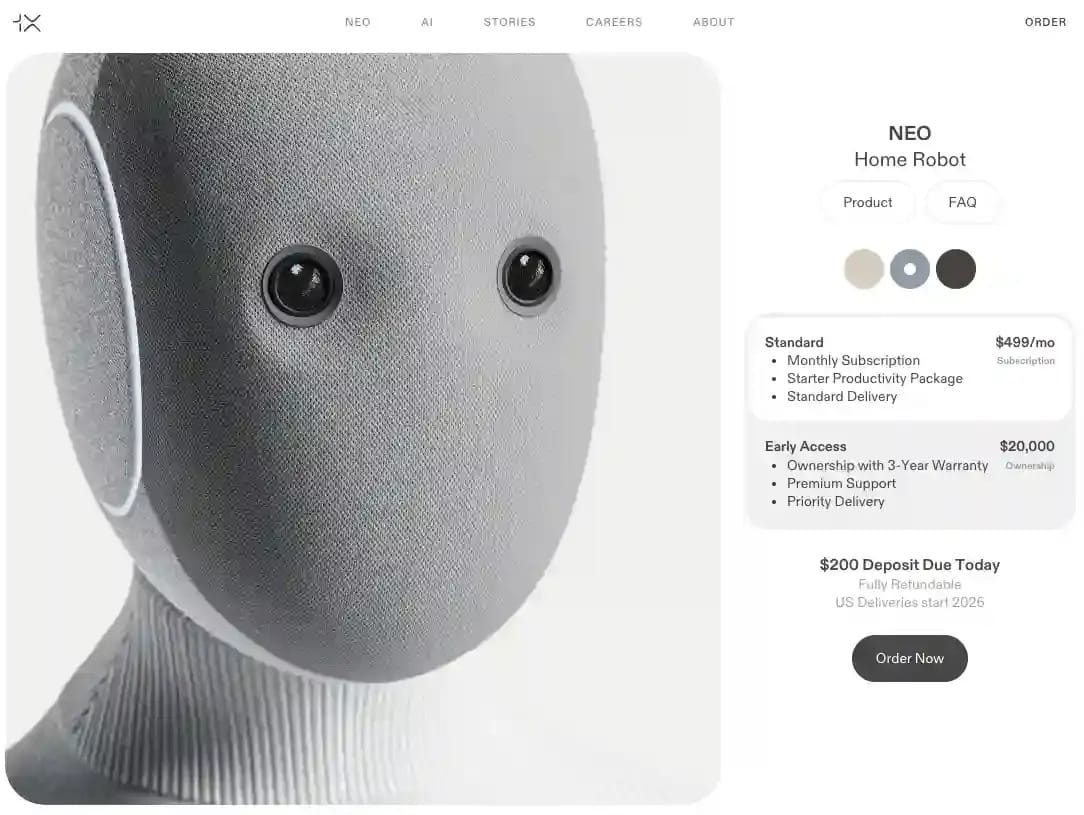

Hace tres semanas os hablaba del Figure 03. Pues bien, esta semana el robot Neo de 1X Technologies (respaldados por OpenAI, por cierto) ya ha salido a venta. Ya tiene fecha de entrega y precio: $20,000 o $499/mes, entregas en EE.UU. en 2026, depósito reembolsable de $200. Ya puedes ir pidiendo el tuyo.

Como cuando te vas a comprar un coche. Fotos a un lado, y precio al otro. Fácil. “Pídelo ya, sin compromiso”

Neo mide 1.68m, pesa 30kg, puede levantar 70kg y cargar 25kg. Es silencioso (22 decibelios, más callado que tu nevera), tiene manos con 22 grados de libertad, y viene en tres colores: tostado, gris y marrón oscuro. Su cuerpo es suave, un polímero mallado 3D, para que no te dé un susto si te lo cruzas de madrugada camino al baño. Y han diseñado sus articulaciones con sistemas de poleas en lugar de los típicos brazos y engranajes motorizados, para hacerlo mucho más ligero. Hasta aquí, todo normal, en la línea con los últimos meses.

Mírale que majo, y hasta puede elegir color cuando te lo estás comprando, como un Iphone. Y cuando se queda sin batería, ya está enseñado y se va él solito a enchufarse un rato.

Pero ahora viene lo bueno (o lo inquietante, según se mire): el "Expert Mode". Los desarrolladores no ocultan que a estas alturas de 2025, Neo no hace apenas nada de manera autónoma. según el vídeo promocional, te abre la puerta, te trae cosas y poco más. Pero la empresa ha tenido un “genial” idea. ¿Que quieres que, por ejemplo, te planche la ropa, pero no sabe hacerlo? No pasa nada, contactas a su atención al cliente, y activan el “Modo experto”, donde un operador humano se conecta al robot y lo controla remotamente con un casco de realidad virtual viendo el tu casa a través de sus cámara. Sí. Un desconocido, desde la oficina, o en China, o Indía, o donde esté, pilotando un robot por tu casa. Para enseñarle.

Piénsalo un segundo: estás pagando $20,000 por un robot que necesita que alguien de la empresa lo maneje en remoto (con tu permiso, eso sí) para aprender a doblar tu ropa. Eso sí, 1X promete que puedes desenfocar caras, crear zonas prohibidas, limitar horarios (ya lo que faltaba si no)... pero vamos, que es teleoperación en tu salón mientras el robot aprenda dónde va tu taza favorita.

El CEO, Bernt Børnich, lo vende como un "contrato social": para que el producto mejore, los early adopters deben estar aceptar compartir datos desde sus hogares. Un poco al estilo Tesla con su Autopilot, que ha estado años poniendo a su flota a aprender a conducir autónomamente mientras tú llevabas el coche y le dabas datos muy valiosos, en realidad. Pero esta vez no lo vas a controlar tú, sino un desconocido que te estará llevando el vaso al fregadero.

La pregunta filosófica de la semana: ¿cuánta privacidad estamos dispuestos a sacrificar por la conveniencia de un robot doméstico? Porque esto no es solo datos en la nube. Es alguien literalmente viendo tu casa. Y la pregunta práctica: ¿podrás comprar varios o se limita a uno por casa? No queda mucho para ver a ricos con varios de estos, especializados cada uno en distintas tareas.

Venga, otra noticia de ciencia ficción, muy en la linea de la semana pasada 👩🚀☀ :

La semana pasada os hablaba de Starcloud, una startup que quería lanzar GPUs de NVIDIA al espacio. ¿Esta semana? Google, siempre Google respondiendo a lo que anuncian otros. Acaban de publicar un “paper” científico diciendo: sujétame el cubata, nosotros llevamos mucho tiempo investigando esto y vamos a lanzar constelaciones enteras de TPUs (los chips de Google especializados en IA). Se llama Project Suncatcher, y no es especulación de startup, es Google haciendo una apuesta lunática con ciencia detrás.

¿Que NVIDIA y Starcloud quieren lanzar una GPU? Nosotros montamos una constelación de satélites con nuestras TPUs.

La idea es “simple”: el Sol emite más de 100 billones de veces la energía eléctrica total que consume la humanidad. En órbita, un panel solar puede ser hasta 8 veces más productivo que en la Tierra, produciendo energía casi de forma continua. Y con la IA chocando contra el muro energético (el coste energético y monetario para alimentar todos los centros de datos que se están construyendo es cada vez más colosal), Google se pregunta: ¿y si nos vamos donde la energía es gratis e ilimitada?

Project Suncatcher propone constelaciones de satélites solares equipados con TPUs, volando en formación cerrada como una bandada de pájaros a ~650km de altitud en órbita sincrónica amanecer-atardecer (luz solar casi constante), comunicándose entre ellos con láseres. Básicamente, un datacenter flotando en órbita, disparándose rayos láser para procesar IA.

Suena a ciencia ficción, pero Google ya ha empezado a resolver los cuatro problemas monumentales (y aquí los tienes en su paper):

1. Comunicación láser ultrarrápida: Necesitan decenas de terabits por segundo entre satélites, como los datacenters terrestres. Ya tienen un prototipo de laboratorio transmitiendo 1.6 Tbps. La clave es volar los satélites en formación súper cerrada (unos pocos kilómetros o menos entre ellos), porque la potencia recibida escala inversamente con el cuadrado de la distancia.

2. Mantener 81 satélites a cientos de metros: Imagina mantener decenas de satélites volando a 100-200 metros unos de otros mientras orbitan la Tierra. Sus modelos de física orbital muestran que con la gravedad terrestre, solo necesitarían maniobras menores de corrección. No es trivial, pero es factible.

3. Radiación espacial: Las partículas cósmicas destrozan circuitos. Google probó sus TPU Trillium con haces de protones de 67 MeV. Resultado: toleran casi el triple de la dosis esperada para una misión de 5 años. Las TPUs resultaron sorprendentemente resistentes a la radiación sin siquiera diseñarlos para eso.

4. Costos de lanzamiento: Históricamente prohibitivos. Pero el análisis de Google sugiere que para mediados de los 2030s, los costos podrían caer a menos de $200/kg. A ese precio, lanzar y operar un datacenter espacial sería comparable al coste energético de uno terrestre por kilowatt/año.

Como no hay imagenes que poner de los satélites en esta noticia, pongo esta imagen que viene muy al caso. ¿Sabes qué es? Es una catapulta gigante diseñada para lanzar satélites al espacio. Literalmente, pone satélites en órbita. SpinLaunch es una de las varias startups que están contribuyendo a abaratar costes de lanzamiento y puesta en órbita de vehículos espaciales o satélites.

Google tiene un acuerdo de colaboración ya hablado con Planet para lanzar dos satélites prototipo en 2027 y validar que los TPUs funcionan en órbita y que los enlaces ópticos soportan la velocidad necesaria para aplicar sus modelos de IA en el espacio.

Ahora, seamos realistas: quedan desafíos enormes (gestión térmica, comunicaciones con la Tierra, fiabilidad on-orbit). Y Google lo reconoce abiertamente. Pero como ellos mismos dicen, este es el mismo equipo que hace una década empezó con computación cuántica cuando parecía imposible, y hace 15 años imaginó coches autónomos que hoy son Waymo transportando pasajeros sin conductor por las calles de EEUU.

Si funciona, cambia completamente las reglas del juego de la IA: energía ilimitada, sin restricciones terrestres, y escalabilidad de vértigo. Si no, pues oye, habremos aprendido dónde están los límites físicos y económicos.

Y hoy, en HistorIAs de la IA tenemos a un conocido por muchos. Sam Altman. CEO de OpenAI, inteligente, mediático, ambicioso…el típico perfil que despierta amor-odio en Sillicon Valley.

HistorIAs de la IA. Hoy: 👤 Quién es quién 👤

Sam Altman: El CEO que fue despedido (por 5 días) y ahora está en juicio

A sus 39 años, Sam Altman dirige OpenAI, la empresa de IA más valiosa del planeta ($500 mil millones de valoración tras su última ronda). Pero su historia no es precisamente de libro (a lo mejor es más de drama de Netflix, de hecho).

Altman, nacido en Chicago en 1985, fue el típico estudiante que entró a Stanford y a los dos años lo dejó para fundar Loopt (una especie de red social basada en la geolocalización que podías compartir con tus amigos, que vendió en 2012). A los 28 ya era presidente de Y Combinator, el acelerador de startups más influyente de Silicon Valley (por nombrar algunas, de Y Combinator han salido Dropbox, Reddit, Twitch, Scale AI, Airbnb, Stripe…).

Pero en 2015 pasó algo que ya es historia de la IA. Cofundó OpenAI con Elon Musk, Ilya Sutskever y otros, como una organización nonprofit (es decir, sin ánimo de lucro) para desarrollar la Inteligencia Artificial General (la famosa AGI) "para beneficio de toda la humanidad". Musk se fue en 2018 tras un intento fallido de fusionar OpenAI con Tesla. Altman se quedó al mando.

Un dato curioso no relacionado con IA sobre Sam Altman: es un preparacionista, o ‘prepper’. ¿Un qué? Uno de esos que tiene su búnker preparado, sus latitas de conservas y pastillas de yodo por si hay un apocalipsis. Pero claro, es un prepper multimillonario, así que también tiene reservas de oro, armas, antibióticos y tierras. Su plan B si colapsa la civilización es irse a una granja con algunos científicos a "reconstruir la tecnología". También tiene preparadas un par de bolsas con todo lo necesario para sobrevivir varios meses. Porque cuando diriges la empresa de IA más valiosa del mundo, nunca está de más tener un plan apocalíptico, supongo 🤷

El punto de inflexión de OpenAI fue ChatGPT, lanzado en noviembre de 2022, lo catapultó a celebridad global. Pero en noviembre de 2023, como ya vimos en nuestro Post #03 (cuando hablamos sobre Mira Murati), el consejo de OpenAI lo despidió sin previo aviso por "no ser consistentemente honesto". Lo que siguió fue puro caos: 738 de los 770 empleados amenazaron con irse, Microsoft ofreció contratarlo, Mira Murati pasó a ser CEO interina, y tras todo el revuelo, cinco días después Altman fue reinstaurado. El board que lo echó (incluido Ilya Sutskever, quien después se disculpó) renunció. Un jaleo.

Ahora sabemos más. Hace pocos días una deposición reciente de Sutskever en el juicio de Musk vs OpenAI revela que Sutskever pasó más de un año preparando un memorándum de 52 páginas detallando un "patrón consistente de mentiras" de Altman: supuestamente enfrentaba ejecutivos entre sí, socavaba a Mira Murati (CTO entonces), y daba versiones contradictorias de cómo manejar la empresa. Sutskever esperó hasta que la composición del board fuera favorable para actuar. Incluso consideraron brevemente fusionarse con Anthropic (competidor fundado por ex-OpenAI) y ceder el liderazgo. Obviamente, no pasó.

De los 11 cofundadores de OpenAI sólo quedan 3 en pie. ¿Será Altman el último que quede en pie?

Siguiendo con los dramas, problemas y negociaciones sobre la reestructuración de OpenAI, que si sin ánimo de luco, que si empresa privada, que si Microsoft tiene una parte u otra… , una demanda de Elon Musk (que lo acusa de traicionar la misión nonprofit), y hasta una demanda personal de su hermana Ann (quien lo acusa de abuso en la infancia, algo que Altman y su familia niegan rotundamente y tanto él como su madre achacan a su hermana de problemas de salud mental).

Lo que no se le puede negar a Altman es su ambición y carisma, y un poquito de contradicción constante: el visionario que democratizó la IA para millones vs el CEO acusado de manipulación interna. El idealista que prometió AGI para la humanidad vs el ejecutivo cerrando rondas millonarias. Su legado aún está por escribirse, pero será, para bien o mal, uno de los más debatidos de la historia (reciente) de la IA, que se está escribiendo. Y en el futuro, le conocerán, si no por su legado en OpenAI, al menos por todos los video-memes que se están haciendo con su avatar en Sora 2.

Y ahora vamos con la herramienta de la semana. Muy útil si te quieres poner al día con la IA 😉

🛠 La Herramienta de la semana

Google Skills: Cursos y certificados de Google que pocos conocen (y que pueden serte útiles)

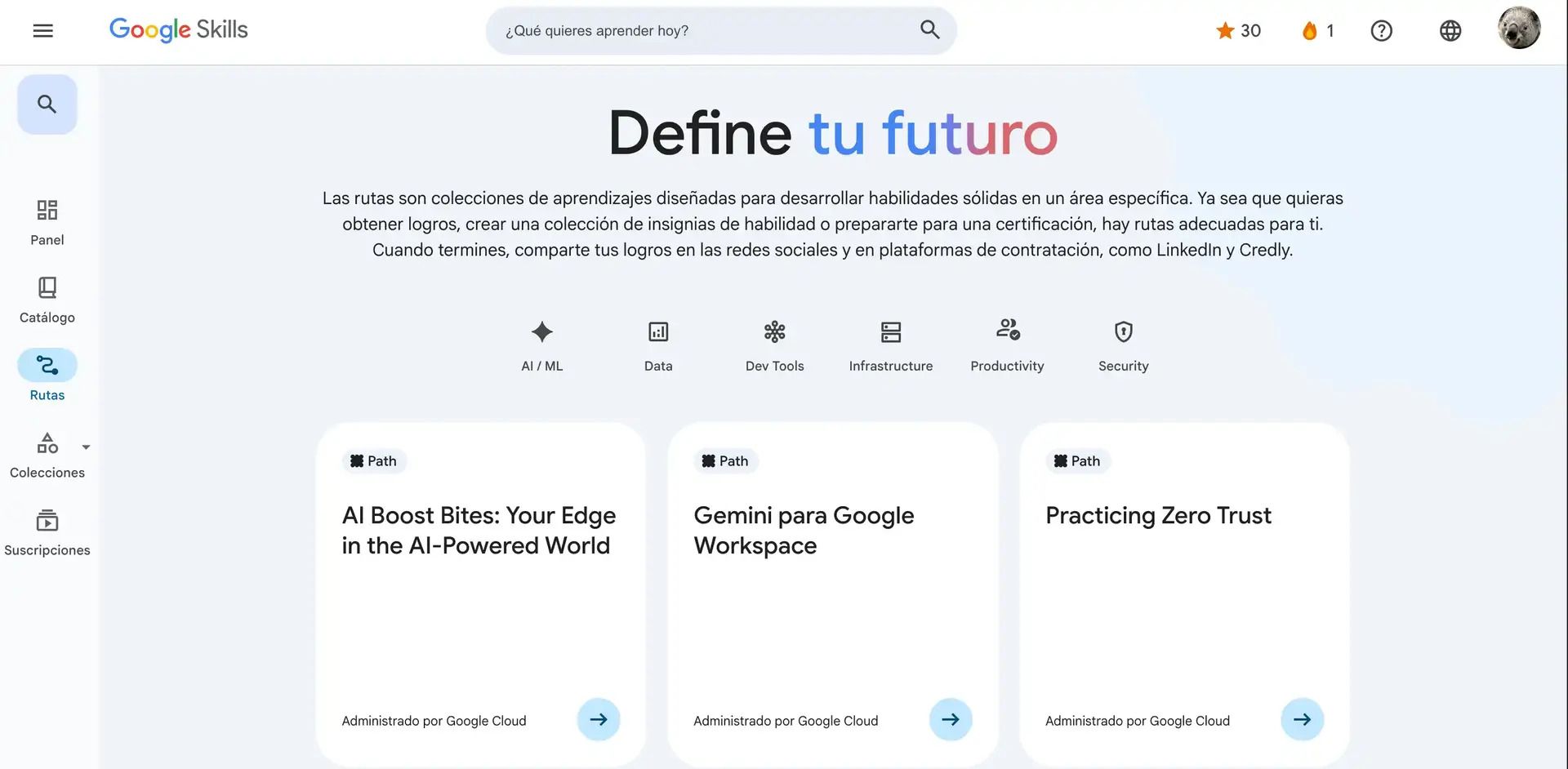

Google tiene una biblioteca extensa de cursos sobre IA que mucha gente desconoce: desde trucos con prompts o introducciones sobre IA generativa en bloques de 10 minutos (busca AI boost bites) hasta cursos completos de varias horas sobre IA, modelos generativos, Cloud, Big Data… Y lo mejor: la mayoría son gratuitos (algunos certificados cuestan, pero tampoco son caros, y no son necesarios).

Así se ve el panel principal o Dashboard. El que no aprende de IA co recuros gratuitos y buenos es porque no quiere 😌

Como muchas cosas que hace Google, la web es muy sencilla e intuitiva, y los cursos que ofrece están bien estructurados, cubren desde lo básico hasta implementación técnica con sus herramientas (Gemini, Vertex AI, etc.). Puedes elegir lo que llaman “Paths” o “Rutas” (sí, la web y muchos cursos están en varios idiomas incluyendo español), donde te van guiando y dando cursos enlazados para un tema que tú pidas. Y si estás buscando upskilling en IA para tu trabajo, esto te puede ahorrar mucho dinero en formación. De hecho ofrecen certificados de estos que al final las empresas valoran que tengan, por si eres de los que necesita hacer estos cursos para hacer tu currículum mas apetecible.

Una vista de las “Rutas”, puedes elegir miles de cursos de IA/ML (machine learning), seguridad, productividad… incluso hay algunos de liderazo y de cómo implementar la IA en tu empresa o equipo a tu cargo

Como es de esperar, están muy centrados en el ecosistema Google. No esperes que te enseñen los trucos de ChatGPT o cómo utilizar Claude Projects. Pero con el enorme ecosistema de Google, no hace falta más. Aprenderás sobre cómo funcionan las IAs generativas para hacer imagen o los LLM para generar esos textos que parecen humanos, y ya luego tú te puedes aplicar el conocimiento a productos que no sean Gemini, Nanobanana, Vertex, Veo, o cualquiera de los de Google.

Una plataforma así es útil porque hay muchas empresas están buscando upskilling (en castellano, que te sigas formando) en IA para sus equipos, y recursos gratuitos de calidad son oro. Si vas a aprender IA desde cero, mejor aprovechar contenido bien estructurado (aunque sea de Google) que perderte en opciones de dudosa calidad.

Y hasta aquí la entrega #10 de la Newsletter, la última de este mes.

¿Qué opinas? ¿Comprarías un Neo sabiendo que alguien puede teleoperarlo en tu casa? ¿Crees que Extropic logrará escalar su locura termodinámica? ¿Y qué te parece la ambición espacial de Google?

Recuerda que puedes puntuar el post y comentar después! 💡 .

🧠 🧠 🧠 🧠 🧠 ¡Alimento para la mente!

🧠 🧠 🧠 Tienes que pensarlo mejor

🧠 Han faltado neuronas

Y si quieres que tus amigos o familiares estén tan al día de la IA como tú, ¡puedes compartirles esta newsletter o mi blog sobre IA! Uno con contenido de actualidad, y otro con artículos más elaborados, que te ayudarán a entender la IA desde otro punto de vista.

>>> Nos vemos en la siguiente entrega 🤝

>>> ¡ Hasta prompto !