Bienvenido al Prompt, la newsletter sobre Inteligencia Artificial escrita con un poco de Inteligencia Natural

¡Hola prompters! 10 de Octubre. Newsletter 06, y qué semanita, otra vez. OpenAI ha decidido que todos seamos developers (aunque no sepamos ni hacer un print("Hola Mundo")) y Google ha respondido con más modelos y propuestas novedosas. Y ¿os acordáis de Thinking Machine Labs, esa startup de Mira Murati que consiguió la mayor valoración en una ronda de financiación semilla antes siquiera de conocerse en qué estaban trabajando? Pues han presentado su primer producto, Tinker, y puede que te interese (pensaba poner Tinkerese como juego de palabras pero me ha dado vergüenza).

Y como estamos en plena semana de los Nobel, recordaremos cuando hace justo un año se lo dieron a los padrinos del deep learning. Spoiler: uno de ellos usó su discurso para advertirnos de que la IA podría acabar mal. Muy tranquilizador todo.

En la newsletter de hoy…:

>>> Tres noticias destacadas

🧑💻 OpenAI DevDay 2025: más aplicaciones, más diversión para los desarrolladores y más futuros usuarios atrapados

💻 La respuesta de Google: un vigilante para tu código y un modelo que maneja tu PC

🧠 Tinker: el primer producto de la startup Dream Team de Murati

>>> HistorIAs de la IA

🎂 Efemérides 🎂 : John Hopfield y Geoffrey Hinton. Premios Nobel a la IA en 2024

>>> Una herramienta

🛠 n8n: El LEGO de la automatización que te habrán intentado vender en Tiktok

Y aquí os dejo la canción que ha hehco la IA para resumir la newsletter de hoy. Hoy toca reggaetón clásico, el OG. Tego Calderón hablándote de las novedades semanales en la IA. Esa no la viste venir.

¿Qué ha pasado esta semana en el mundo de la IA?

El pasado lunes OpenAI presentó su DevDay 2025. Un evento donde mostró varias novedades, esta vez más enfocadas hacia desarrolladores y programadores. Hubo anuncios sobre nuevos modelos incluidos en la API, (como GPT-5 pro, Sora 2 o gpt-image-1-mini), pero lo más destacado fueron los dos siguientes lanzamientos: AgentKit para que los desarrolladores puedan crear sus propios agentes, y un kit de desarrollo que permite a las compañías incluir sus aplicaciones en el propio chat de ChatGPT. Veamos un poco más a fondo qué son estos dos productos:

AgentKit es un kit de herramientas de software (SDK) para desarrolladores diseñado para simplificar radicalmente la creación, el despliegue y la optimización de agentes de IA. Es la apuesta de OpenAI para convertirse en la plataforma donde se construyan todos los futuros "trabajadores digitales". Están diciendo a los 4 millones de desarrolladores de su ecosistema: "Dejad de hacer solo chatbots. Aquí tenéis las piezas de LEGO para construir AIs que hagan cosas de verdad, y nosotros nos encargamos de que sea fácil y funcione a escala". Esto no es nada nuevo, y de hecho, tanto la idea como la estética se parecen sospechosamente a herramientas de creación de automatizaciones que ya llevan años en el mercado como n8n (de la que hablaremos al final del post de hoy)

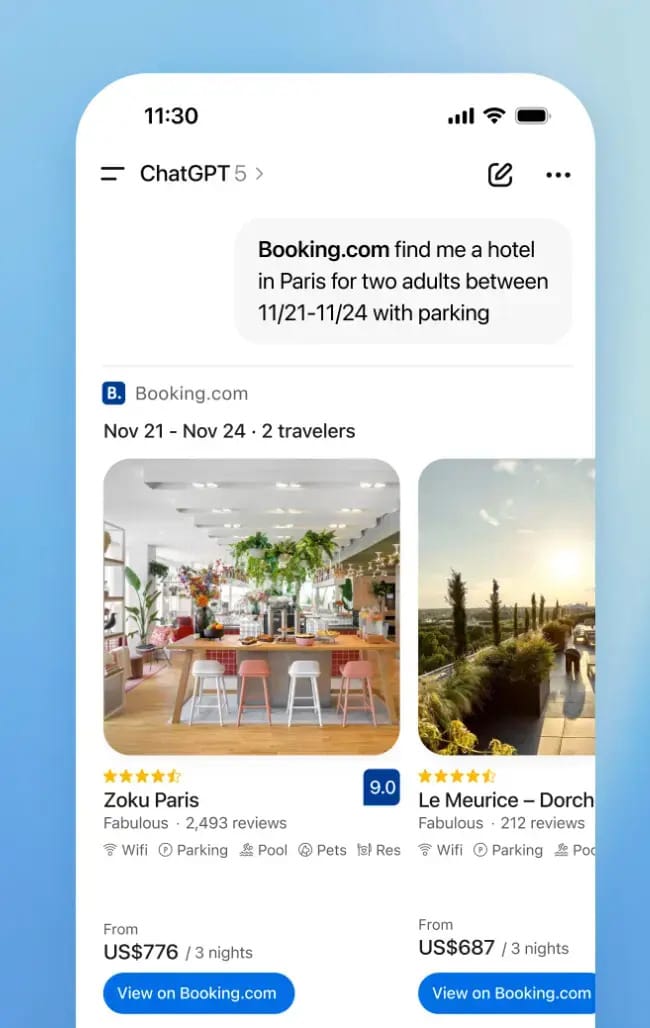

Por otro lado, han anunciado la integración de aplicaciones de terceros (como Figma, Spotify, Booking.com…) en ChatGPT. ¿Cómo? ¿Por qué? Muy sencillo. Siguiendo la línea de lo que contábamos la semana pasada donde ChatGPT ya permitía la venta de artículos de Etsy desde el chat, ahora quieren que no te tengas que salir de tu conversación en ChatGPT si quieres crear una lista de música, reservar un hotel o comprar una casa. Si por ejemplo dices “hazme una lista de música de Spotify de 2025 en base a mis gustos”, ya no te creará una simple lista que tendrás que ir metiendo a mano en Spotify sino que te abrirá Spotify dentro del Chat y creará la lista dentro, todo sin cambiar la ventana. Lo mismo si estás buscando hotel con Booking.com o diseñando una web con Figma. Hay muchas más aplicaciones ya anunciadas (Uber, Opentable para reservar, Doordash para pedir a domicilio, Target para comprar…) que irán siendo incluidas poco a poco, pero además han creado un SDK para que cualquier aplicación haga el trabajo de integrarse en el chat en una simbiosis donde a ChatGPT le encantará que no salgas de su ventana y a la aplicación le encantará tener acceso a los más de 800 millones de usuarios activos que OpenAI dice que tiene. Otra jugada maestra.

Así se ve la integración de Booking.com en ChatGPT. Otra jugada maestra de OpenAI

¿Y por qué tanto esfuerzo extra con desarrolladores? Fácil. El número de developers usando las herramientas de OpenAI se ha duplicado a 4 millones, y el uso de la API ha aumentado de 300 millones de tokens por minuto a 6 mil millones. Y la verdad es que otra cosa no, OpenAI no para de darnos ejemplos de aplicaciones de la IA en el día a día de un usuario. Lleva varios meses a varios anuncios por semana, casi.

Justo cuando OpenAI presentaba su AgentKit, Google, que no sabe estarse quieto, contraatacó con dos novedades de Gemini que también han dado que hablar. Y no es coincidencia el timing. T

odo el mundo sabe que a este nivel, estas empresas se espían y conocen más o menos qué va a ir sacando su rival. Está claro que Google sacó estas dos noticias el mismo día y el día después del OpenAI DevDay no por casualidad. Pero también te digo, hay que tener estos productos ya listos y en el cajón esperando al momento adecuado, que no son proyectitos que habrán hecho en un par de días

Primero, CodeMender, un agente de IA diseñado para ser el vigilante de seguridad de tu código. Su única misión es encontrar vulnerabilidades y proponer soluciones. En sus pruebas, fue capaz de solucionar el doble de problemas de seguridad que las herramientas existentes.

Piensa en las herramientas de seguridad tradicionales como una alarma de incendios: suena y te dice dónde está el fuego. CodeMender es como un bombero-robot: oye la alarma, va al lugar del fuego, y lo apaga por sí mismo. ¿Cómo funciona?

Identifica la Amenaza: Utilizando modelos de Gemini, escanea el código en busca de vulnerabilidades conocidas (inyección de código, exposición de datos, etc.).

Comprende el Contexto: Aquí está la clave. No se limita a mirar una línea de código aislada. Analiza todo el repositorio para entender cómo una vulnerabilidad podría ser explotada y cuál es la mejor manera de arreglarla sin romper otras partes del programa.

Genera la Solución: Escribe el código del parche. No es una sugerencia genérica, es el código específico que el desarrollador puede implementar.

Verifica la Solución: Comprueba que el parche realmente cierra la vulnerabilidad y no introduce nuevos errores.

Y al día siguiente, Gemini for Computer Use. Este modelo convierte a Gemini en un agente que puede controlar tu ordenador. No es que te escriba un email, es que abre tu cliente de correo, adjunta el archivo correcto y lo envía por ti. En las demos, se le ve organizando archivos, rellenando hojas de cálculo y creando diapositivas. Es la visión definitiva del "becario digital": un sistema al que le das una tarea y la ejecuta usando las mismas herramientas que usarías tú.

¿Cómo Funciona?

Observa la Pantalla: El modelo procesa lo que se muestra en la pantalla (iconos, texto, botones, imágenes).

Entiende los Elementos: Identifica qué es un botón clicable, un campo de texto para rellenar o un menú desplegable.

Crea un Plan de Acción: Basado en la petición del usuario, descompone la tarea en una secuencia de acciones (Ej: "Abrir Chrome" -> "Hacer clic en la barra de búsqueda" -> "Escribir 'Gmail'" -> "Hacer clic en el enlace de Gmail"...).

Ejecuta las Acciones: Controla el cursor del ratón y el teclado para llevar a cabo el plan.

Venga que una newsletter sin algún benchmark del último modelo de la IA en algo no es lo mismo. Aquí se ve cómo este Gemini 2.5 Computer Use es más rápido y más preciso que lo que había hasta ahora.

Podrías pensar que para qué vas a dar acceso a Gemini a que mire tu pantalla para mirar un email. Y tendrás razón. Pero piensa en otras aplicaciones: muchas tareas diarias ocurren en aplicaciones que no tienen APIs. Este modelo salta esa barrera, permitiendo automatizar flujos de trabajo que hasta ahora eran exclusivamente manuales. Y además, y más importante, este modelo convierte el lenguaje natural en la interfaz definitiva para controlar cualquier software, lo que tiene implicaciones enormes para la accesibilidad y la productividad general. Es la forma de interactuar con la tecnología más intuitiva posible, y permitirá interactuar de manera fluida a quien no puede mover un ratón, ver una pantalla, o manejar un ordenador de forma habitual

La estrategia de Google es clara: si OpenAI te da las herramientas para construir agentes, Google te da agentes ya especializados y listos para usar. La batalla ya no es sobre quién tiene el chatbot más listo, sino sobre quién crea el asistente más útil.

¿Os acordáis de Mira Murati, nuestro personaje del post #03? La ex-CTO de OpenAI que en Octubre de 2024 emprendío su vuelo en solitario para crear Thinking Machine Labs, una startup que se hizo mundialmente famosa al ser la startup que mayor financiación ha obtenido en una ronda semilla en la historia. 2.000 millones de dólares por una startup que no tenía un producto. Bueno pues ya tiene uno. Acaba de anunciar Tinker. Y el producto no está mal, pero todo el mundo esperaba mucho más.

Esperaban mucho más porque al fin y al cabo, esta startup se había formado con miembros de las mejores empresas y los mejores últimos desarrollos: además de Mira Murati (con el liderazgo en el desarrollo de ChatGPT o DALL·E a sus espaldas) había un cofundador de OpenAI y desarrolladores de herramientas o modelos muy importantes en los últimos años como como Mistral, Pytorch, Segment Anything.. Y de semejante Dream Team se esperaba que su primer lanzamiento fuese rompedor. Pero no ha sido así.

Es como si se juntan algunos de los mejores músicos, con un cantante top, los productores con más dinero y algunos letristas con las letras de canción más originales, y en lugar de sacarte el hit de la década te sacan una intro para una serie de televisión. Muy bien, muy mona, cumple su función, pero no es la canción del siglo

Entonces, ¿qué es exactamente esta "intro de serie"? Tinker es un taller de alta mecánica para IAs. Es una API diseñada para que desarrolladores y investigadores puedan coger un modelo de código abierto (como LLaMA de Meta) y hacer fine-tuning ("tunearlo", o hacer un ajuste fino) a su gusto. En lugar de usar el motor de fábrica que te da OpenAI, Tinker te da las herramientas de precisión para que modifiques la centralita, ajustes la suspensión y especialices ese motor para correr en un circuito muy concreto, ya sea el de la química molecular o el del análisis legal.

Éste es el logo de Tinker, que tiene más historia de la que parece. ¡Lee al final del post para un dato curioso!

Para ello, se basa en una técnica llamada LoRA (Low-Rank Adaptation), que, para que nos entendamos, es una forma muy eficiente de hacer estos ajustes sin tener que reconstruir el motor entero desde cero. Es más barato, más rápido y menos aparatoso. Y lo que proponen ellos es que tú traes el conocimiento del objetivo para el que quieres ajustar el modelo, eliges un modelo de su lista de opciones, y ellos te proporcionan una API para que este fine-tuning sea eficiente y no te tengas que preocupar de mantener el hardware a punto, controlar que el proceso no se cuelga, etc, ya que se ejecutará en sus servidores, y ellos se encargarán de gestionarlo

Y aquí está la clave: aunque no es el blockbuster que todos esperaban, Thinking Machines ha sido muy inteligente. Han apuntado a un nicho que, sorprendentemente, aún no está saturado: las herramientas de "fontanería" para la IA. Y si lo hacen muy bien, tendrán una buena parte de la comunidad desarrolladora y científica de su lado, ya que su propuesta alivia una carga que quita del foco al investigador que sólo quiere que su modelo funcione para su fin. De hecho, Tinker ya ha sido usado por universidades tan importantes como Berkeley, Princeton o Stanford.

La especulación en los mentideros de Silicon Valley es que esto es solo el aperitivo. Que Tinker es la primera fase de un plan mayor: una forma de atraer a los desarrolladores más listos, entender sus necesidades y, quizás en una o dos versiones, lanzar la verdadera "canción del siglo". O quizás no. Quizás el plan siempre fue convertirse en el proveedor de herramientas de lujo para la nueva élite de la IA.

De momento, el Dream Team no ha lanzado el hit del verano, pero ha construido un estudio de grabación impecable. Ahora falta ver si lo usan para grabar su propia obra maestra o si se conforman con alquilárselo a otros artistas.

Y para los que les gusta encontrar conexiones, aquí va un dato curioso:

El logo de Tinker, de la figura de arriba, es una visualización esquemática inspirada en el “Tinker Toy Computer” original. ¿Sabéis quienes crearon este TinkerToy Computer en 1978? Brian Silverman y Danny Hillis. ¿Sabéis qué más fundó Danny Hillis? Thinking Machines Corporation, una empresa dedicada a crear supercomputadores con nombre sospechosamente parecido al de la startup que nos ocupa, y en la que trabajaron algunas de las mejores mentes del siglo XX como Richard Feynman (Nobel de Física entre otras muchas cosas), Marvin Minsky (otro de los padres de la IA), Stephen Wolfram (creador de Wolfram Mathematica) y muchos más. Además, por si era poco ¿quién fue uno de los directores de tesis de Danny Hillis? Claude Shannon, de quien Anthropic tomó el nombre para nombrar Claude a sus modelos.

¿No es todo muy 🤯 ? ¿O soy yo que ya veo conexiones en todas partes?

Y ahora, ya que estamos en plena semana de anuncios de los Premios Nobel, vamos a recordar una efemérides de hace tan sólo un año, muy relacionada con la IA.

HistorIAs de la IA. Hoy: 🎂 Efemérides 🎂

John Hopfield y Geoffrey Hinton: cuando los Nobel aceptaron las redes neuronales como avance de la física

Hace (un poco más de) un año, el 7 de octubre de 2024, el comité del Nobel hizo algo que muchos consideraron inevitable pero igualmente histórico: le dieron el premio de Física a John Hopfield y Geoffrey Hinton por sus contribuciones a las redes neuronales artificiales.

John Hopfield, físico de Princeton, creó en 1982 las "redes de Hopfield", un modelo que usa principios de física estadística para crear memorias asociativas. ¿KeH? Voy a intentar resumirlo en un par de líneas, que no se diga que no lo he intentado: Imagina que no recuerdas bien el nombre de una ciudad que has visto hace poco escrita, te viene “Champín”, o “Chonchín”.. empiezas a darle vueltas (a iterar) hasta que tras unas cuantas combinaciones la que más te suena (la que menos energía tiene, en términos de física estadística) es Chongqin. Listo, tus neuronas encargadas de recordar la palabra tenían almacenado un patron similar, con algunas letras iguales, y te ha permitido recordar la palabra que una vez escuchaste.

Mírales qué majos. John Hopfield (92 años) a la izquierda, y Geoffrey Hinton (77 años) a la derecha.

Por otro lado, Geoffrey Hinton es conocido como “el padrino del Deep Learning” (normal, también te digo, si uno de sus paper más importantes se titula “Deep Learning”). Revolucionó el campo con el algoritmo de backpropagation y las máquinas de Boltzmann. En cristiano: descubrió cómo hacer que las redes neuronales aprendan de sus errores. Sin esto, no existiría ChatGPT, ni DALL-E, ni nada de lo que llamamos IA hoy. Si me pongo a hablaros de máquinas de Boltzmann después de la redes de Hopfield a lo mejor no volvéis, así que dejo el tema para un post futuro donde hable en profundidad de su trabajo.

Por ahora nos quedamos con algo curioso, como es que Hinton usó su discurso de aceptación para básicamente decir "cuidado que puede que hayamos creado un monstruo". De hecho, Hinton había dejado Google meses antes específicamente para poder hablar libremente sobre los riesgos de la IA.

El Nobel de Física para un trabajo en IA fue controvertido. Muchos físicos tradicionales pusieron el grito en el cielo. Pero el comité tenía un punto: los principios que gobiernan el aprendizaje de las redes neuronales no están tan lejos de la física de la materia condensada, la nuclear o la física estadística y son los mismos que gobiernan cómo se organizan los átomos en un cristal o cómo fluye la energía en un sistema.

Si queréis leer el documento en el que hablan del trabajo de ambos con algo más de profundidad, pero fácil de entender, podéis verlo aquí. Y por último, dejadme que acabe con dos datos curiosos:

1. Las redes de Hopfield tienen más relación con la resonancia magnética de lo que pensabas)

La teoría de redes de Hopfield está fuertemente inspirada en los spin glasses (¿vidrios de spin?), que son sistemas complejos donde el spin de sus elementos determina el estado de energía del sistema, igual que la energía de las redes de Hopfield es quien manda sobre el estado de la red. ¿Y la relación con la resonancia magnética? Pues que hay un efecto, el conocido como efecto nuclear Overhauser, que consiste en la transferencia de polarización de espín de una población de espines a otra mediante la relajación cruzada. OK, ¿y lo curioso? Pues que el señor que describió este efecto, Albert Overhauser fue director de tesis y mentor de John Hopfield. Es decir que el pobre Hopfield de tanto escuchar a su supervisor con su tema, le debió inspirar su charla diaria para desarrollar el trabajo que le acabaría dando un Nobel. Conclusión: escucha a tu supervisor de tesis que a lo mejor te dan un Nobel por eso.

2. Si quieres saber si la investigación de un científico es relevante, prueba a mirar en Google Scholar cuántas citas tiene.

No es una condición que se cumpla siempre, y no te puedes guiar solo por eso, pero si ves a un investigador con casi un millón de citas en revistas científicas, puedes estar seguro de que ha hecho muchas cosas muy bien. Es el caso de Geoffrey Hinton. Si le buscas en Google Scholar (la herramienta de Google que trackea las citaciones y producción científica de los investigadores). No solo tiene 950.000+ citas sino que casi 600.000 son de apenas los últimos 5 años. No llega a los números de Ibai o Cristiano Ronaldo, pero en la comunidad científica esos números son muy grandes.

Y hasta aquí la charla de física y ciencia, perdonad si se me ha ido de las manos 🤓 👌

"Déjate de máquinas de Boltzmann y redes de Hopfield y dime más herramientas donde pueda aplicar la IA y hacerme rico con ella” — estarán pensando algunos (prometo que el guión este lo he puesto yo, y no ChatGPT).

Vamos a ellos, veamos una aplicación que ya existía antes del boom de la IA, pero que ha sabido aprovechar todo su potencial para resurgir más fuerte que nunca.

🛠 La Herramienta de la semana

n8n: El LEGO de la automatización

Justo cuando OpenAI anuncia su SDK para crear agentes con código, merece la pena echar un vistazo a n8n, que lleva años haciendo algo parecido: todo es visual, todo es componible, y todo puede vivir en tu servidor si eres de los paranoicos con la privacidad.

n8n (es una herramienta creada por Jan Oberhauser (no es familiar del Albert Overhauser, creo, pese al parecido en el apellido… ¿coincidencia que aparezcan los dos hoy? quizá…). Básicamente, n8n básicamente un lienzo infinito donde arrastras nodos (Gmail, Slack, ChatGPT, Whatsapp, tu nevera inteligente si te da la gana) y los conectas con flechitas para crear automatizaciones.

Así se vería una automatización en n8n. En este caso, cada semana, se ejecuta este flujo donde se buscan en la cuenta que hayas asociada en Facebook, LinkedIn y Twitter las analíticas, se formatean, unen y se guardan en un informe que además se te envía por email. Todo sin que tú muevas un dedo, automáticamente. ¿No os parece el diseño como muy parecido al recién anunciado Agent Builder de OpenAI?

Un punto fuerte de n8n es que puedes empezar arrastrando cajitas como si fueras un niño de cinco años con bloques de construcción, y acabar creando automatizaciones complejas que hagan lo que se te ocurra. Por ejemplo:

- Buscar anuncios de coches de segunda mano en tu zona y enviar una propuesta de compra más barata y avisarte por whatsapp si el dueño acepta

- Leer tus emails, organizarlos, contestar los poco relevantes, eliminar los no importantes, y enviarte un resumen personalizado al principio del día de los que tienes que leer

- Leer noticias de IA, generar una newsletter, generar imágenes, subirlas a un gestor de newsletters y enviar un email semanal (🙄)

En realidad, n8n ya podía hacer todo esto antes de la IA. Entonces ¿por qué el boom de ahora, y en qué ha mejorado? Muy sencillo: con los LLMs integrados, ahora puedes crear flujos que no solo mueven datos de un lado a otro como un cartero digital, sino que los entienden, los procesan y toman decisiones. Tu Gmail puede decidir solo qué emails merecen interrumpirte basándose en el contexto, no solo en palabras clave.

¿El precio? Tienes versión gratuita self-hosted (si tienes un servidor y ganas de trastear), o desde 20€/mes para la versión cloud donde ellos se encargan de que todo funcione. ¿Los contras? Si no quieres pagar, el self-hosting puede ser un dolor, la curva de aprendizaje es empinada cuando quieres hacer cosas complejas y robustas, y el marketplace de templates (gratuitas) es relativamente limitado.

n8n lleva años democratizando la automatización con cajitas y flechas. Pero tras el anuncio de Agent Builder por parte de OpenAI, muchos usuarios han pensado que la batalla de David contra Goliat en el terreno de la automatización y creación de aplicaciones con bloques acaba de empezar.

El futuro probablemente no sea uno u otro (u otros similares a n8n como Zapier o Make), sino todos, aunque si eres una startup en este espacio... buena suerte. Vas a necesitarla.

Y hasta aquí la entrega #06 de la Newsletter.

Recuerda que puedes puntuar el post y comentar después, por si quieres dar ideas, quejas, sugerencias, peticiones… 🤓 .

🧠 🧠 🧠 🧠 🧠 ¡Alimento para la mente!

🧠 🧠 🧠 Tienes que pensarlo mejor

🧠 Han faltado neuronas

Y si quieres que tus amigos o familiares estén tan al día de la IA como tú, ¡puedes compartirles esta newsletter o mi blog sobre IA! Uno con contenido de actualidad, y otro con artículos más elaborados, que te ayudarán a entender la IA desde otro punto de vista.

>>> Nos vemos en la siguiente entrega 🤝

>>> ¡ Hasta prompto !