Bienvenido al Prompt, la newsletter sobre Inteligencia Artificial escrita con un poco de Inteligencia Natural

¡Hola suscriptores! 11 de Septiembre (segunda newsletter del mes) y, de nuevo, no han faltado noticias de las que hablar. Vamos con ellas, y después… ¡nueva sección 🥳 !

En la newsletter de hoy…:

>>> Tres noticias destacadas

💸 Trump reúne en una cena a (casi) todos los CEOS de las grandes tech AI de EEUU

😵💫 OpenAI publica un artículo sobre por qué los modelos alucinan

🇨🇳 Anthropic cierra la puerta a China: “nación adversaria”.

>>> HistorIAs de la IA

👤 Quién es quién: Alexandr Wang, un Supercerebro para crear la Superinteligencia

>>> Una herramienta

🛠 LM Arena. Donde los chatbots luchan anónimos por el título

¿Qué ha pasado esta semana en el mundo de la IA?

Donald Trump organizó el pasado viernes 5 de Septiembre una cena a la que fueron invitados todos los líderes de las grandes tech involucradas en IA. Aunque más que cena, aquello parecía un concurso de “Quién da más por la IA americana”. Oficialmente, según el comunicado de la Casa Blanca, se trataba de “alinear al sector tecnológico con la estrategia gubernamental para consolidad el dominio estadounidense en IA”. Y también, dicen “se trató de una colaboración público-privada para acelerar la innovación y expansión de infraestructura tecnológica, en el marco del plan estratégico nacional denominado AI Action Plan”. Ese mismo día “La Primera Dama impulsó complementariamente una agenda educativa basada en IA para preparar a las futuras generaciones”.

Dicho de otro modo, menos propagandístico: pasó lista y reunió a todos los CEOs de las grandes tecnológicas en una cena donde, uno por uno, fueron 1) agradeciendo ser invitados, 2) elogiando el papel de Trump en la economía y el apoyo al mercado y la tecnología y 3) diciendo cuánto iban a invertir en los próximos años en Inteligencia Artificial para EEUU y para la educación en concreto. Satya Nadella (Microsoft) abrió con 80.000 millones anuales. Pichai subió la apuesta a 250.000 millones desde Google. Sam Altman (OpenAI) recordó su Stargate de 500.000 millones con Oracle y Softbank. Tim Cook (Apple) llegó a los 600.000 millones... Y Zuckerberg (Meta), que pareció que no había hecho los deberes, también dijo 600.000 millones pero luego le confesó, sin saber que el micrófono seguía abierto, que: “no sabía qué cifra quería que dijera”.

Google, Meta, Microsoft, OpenAI, Oracle, AMD, Figma, Palantir, Micron Technology… Ni con el 0.5x dela cámara del móvil habrían podido meter a todos los CEOs en la misma foto.

Por cierto, me gustaría ver la conversación del grupo de Whatsapp para poner una fecha que les fuera bien a (casi) todos los CEOs de las grandes tecnológicas de EEUU. Y es “casi” todos porque hubo dos sonadas ausencias: Jensen Huang, CEO de NVIDIA, y Elon Musk, CEO de Tesla, SpaceX y cofundador de Neuralink y (sí, también) OpenAI. De Jen-Hsun Huang dicen que no es él muy del reuniones grande, y que prefiere charlar uno a uno con Trump. Y Elon Musk dijo que sí que estaba invitado, pero que no podría ir, tampoco se preocupó mucho de poner excusa, en realidad.

OpenAI publicó el 5 de Septiembre un artículo donde explica por qué los modelos alucinan, (y propone cómo solucionarlo). Sus autores concluyen que las alucinaciones de los modelos no son un fallo misterioso, sino la consecuencia lógica de cómo los entrenamos y evaluamos. Por alucinación entienden esas respuestas falsas pero convincentes. Un ejemplo: preguntar la fecha de nacimiento de Adam Kalai (autor del paper). Distintos chatbots devolvieron tres fechas distintas, todas incorrectas.

El estudio explica que el problema empieza en el pre-entrenamiento. Los modelos aprenden a predecir la siguiente palabra, no a distinguir verdad de mentira. Y continúa en el post-entrenamiento: la mayoría de benchmarks castigan más un “no lo sé” que un error seguro. Es como el típico examen tipo test donde no penaliza fallar, y como el cero ya lo tienes, te la juegas a ver si suena la flauta. Solo que en lugar de haber una respuesta objetivamente cierta o errónea, a veces es interpretable, y puede convencer al evaluador si la formula una respuesta con la suficiente confianza. Resultado: el modelo no solo prefiere hablar antes que callar o decir “no lo sé”, sino que lo dice son fingida seguridad, porque el entrenamiento le ha demostrado que así mejora su probabilidad de éxito (de colarte el triple).

Ante esto, no basta con entrenar los modelos con más millones de parámetros, más tiempo y más conocimiento. Es imposible que el modelo aprenda todo, por muy intensivo que sea el entrenamiento, porque aunque tenga un 0% de fallos en ortografía o distinga un perro de un gato el 100% de las veces, si le pides el cumpleaños de un perro, no sabrá la verdad objetiva. Para evitar que mienta, la propuesta de OpenAI es sencilla pero ambiciosa: cambiar la manera de evaluar. Penalizar las respuestas falsas más que la abstención, y dar crédito parcial a la incertidumbre. Y parece que algo han hecho en el entrenamiento de sus propios modelos, porque se puede ver una tendencia esperanzadora en la reducción de alucinaciones en GPT-5 con respecto a modelos de generación anterior:

En conclusión: para reducir alucinaciones, no basta con modelos más grandes. Hace falta cambiar los benchmark y la manera en que se evalúan los modelos. Eso sí, todo esto sólo aplica al modo de generación de texto. Las alucinaciones en imagen o video tienen otras causas, otros problemas y otros soluciones.

Os dejo aquí el enlace de arXiv a la publicación, por si quieres leerlo (o pedirle a ChatGPT que te lo resuma… sería irónico que alucinase en su resumen, ¿no?). Que en realidad no es un artículo científico, publicado en una revista con revisión por pares, sino en un preprint en arXiv. Los tiempos de la investigación en IA son tan rápidos que es muy habitual que trabajos como este salgan en arXiv antes, pero habrá que esperar al rigor científico de una revisión por expertos para dar por bueno su planteamiento.

Anthropic acaba de endurecer sus restricciones de acceso a Claude, ampliando el veto que ya tenía vigente a países como China, Cuba, Venezuela, Irán, Rusia y Corea del Norte para incluir ahora a cualquier empresa controlada, directa o indirectamente por entidades chinas en al menos un 50%, aunque estén basadas fuera de China. Es decir, que una startup en, por ejemplo, Singapur tiene como dueño mayoritario a una empresa china, que antes tenía acceso a la API de Claude, desde la semana pasada ya no tendrá; se acabó Claude para ellos.

La medida de Anthropic, que dice que es "la primera en la industria", según anuncian no es solo simbólica. Según un ejecutivo de la compañía, el impacto en sus ingresos globales será de "varios cientos de millones de dólares". Reconocen que perderán negocio frente a competidores, pero consideran que era necesario para destacar que este es un "problema significativo".

Anthropic ha decidido que prefiere perder dinero antes que facilitar involuntariamente el desarrollo de IA en regímenes que considera adversarios. Y esta palabra, “adversario”, no es casual, ya que la menciona hasta cuatro veces en su comunicado del pasado 4 de Septiembre. En el comunicado, insisten en que “abogan por fuertes políticas restrictivas a naciones autoritarias que puedan usar sus modelos o destilarlos, para crear tecnología avanzada con fines militares o que atenten contra la seguridad nacional de EEUU o sus aliados”. Un tono muy directo y una postura arriesgada en un mercado tan competitivo, pero que marca un precedente interesante para el resto de la industria.

La pregunta es: ¿seguirán OpenAI, Google y Meta el mismo camino, o aprovecharán para ganar cuota de mercado? Viendo la cena que hubo la semana pasada, no me extrañaría que hubiera acciones similares de otros, en caso de que guerra fría digital se intensifique.

Por cierto, hablando de seguridad y las maldades que se pueden hacer con Claude, el pasado mes la misma Anthropic publicó su informe sobre amenazas a la seguridad que se han producido con su modelo. 25 páginas de ejemplos reales donde criminales ya han usado Claude para ejercer el mal. Os dejo el enlace aquí, por si queréis coger ideas (sobre lo que no hay que hacer, claro).

🚨 Nueva sección en HistorIAs de la IA 🚨

Hoy HistorIAs de la IA estrena categoría. Tras las Efemérides de la anterior entrega, hoy se inaugura “Quién es quién”. Un huequito de la newsletter donde iré hablando de personas importantes del pasado, el presente o el futuro del mundo de la IA, para que no te pierdas entre tantos nombres, o que los puedas dejar caer en conversaciones con amigos y que así demuestres que tú sí estás al día (porque sigues la Newsletter). Pero ojo 👀 , que “Efemérides” y “Quién es quién” son solo dos de las cuatro categorías que formarán esta sección. ¡Seguid atentos que aún quedan dos tipos más!

HistorIAs de la IA. Hoy: 👤 Perfiles 👤

A sus 28 años, Alexandr Wang ya es CEO de una empresa valorada en 7.300 millones de dólares, el multimillonario más joven de Estados Unidos, y ahora, el flamante Chief AI Scientist de Meta para liderar su "Laboratorio de Superinteligencia". No está nada mal para alguien que empezó etiquetando imágenes para entrenar algoritmos.

En 2016, con 19 años, Wang fundó Scale AI junto junto Lucy Guo con una idea aparentemente simple: las IAs necesitan datos de calidad para aprender, y alguien tiene que etiquetar esos datos manualmente. Mientras otros trabajaban en algoritmos revolucionarios, él se centró en el trabajo sucio pero esencial de etiquetado de datos, cerrando acuerdos millonarios con grandes clientes como Google, Oracle, OpenAI o el gobierno de EEUU. Aquen en realidad, el trabajo sucio de etiquetar manualmente todos estos datos no lo hizo él sino los 200.000+ trabajadores de países como Kenia, Pakistán, Venezuela o Filipinas que son contratados en remoto por Remotasks, la empresa filial de Scale AI, en condiciones rodeadas de polémica.

El pasado junio Meta adquirió el 49% de Scale AI por 14.900 millones de dólares, e incorporó a Alexandr Wang como Chief AI Scientist. Este fichaje no fue casual: combina la experiencia práctica de entrenar IAs masivas con la visión estratégica que necesita Zuckerberg para competir con OpenAI y Google. Y prueba de su visión innovadora es la jugada que anunció recientemente en su cuenta de X, la alianza con Midjourney que anunciamos la pasada semana. muestra su estilo: no solo busca modelos potentes, sino "estética". Wang entiende que en la era post-GPT, la diferenciación no está solo en la capacidad técnica, sino en cómo se percibe y se siente la tecnología.

Alexandr Wang, en Febrero de 2025 en el Paris AI Summit. (Gonzalo Fuentes / Reuters)

🛠 La Herramienta de la semana:

La semana pasada ya hablamos de LM Arena, la plataforma donde Nano Banana se dio a conocer al público y destrozó a sus rivales. Hoy te explico cómo funciona, y por qué es una herramienta que merece la pena consultar de vez en cuando.

Como dijimos, LM Arena es una web donde se clasifican todos los modelos de IA en base a una puntuación. Hay distintos rankings (texto, video, programación, búsqueda, multimodal…) pero todos ellos se construyen igual: usuando el sistema ELO de ajedrez. Cada modelo empieza con 1000 puntos, y cada victoria o derrota ajusta las puntuaciones matemáticamente según la "dificultad" del oponente. Un modelo desconocido puede trepar al top del ranking si consistentemente gana batallas, sin que nadie sepa de qué empresa viene. Pero ¿cómo funcionan esas batallas?

La mecánica es sencilla: Entras en LM Arena, lanzas un prompt, el que quieras. dos modelos de IA responden de forma completamente anónima, tú votas por la respuesta que más te convence, y solo después descubres si elegiste GPT-4, Claude, Gemini, o algún modelo experimental que nadie conoce. Con tu voto, y el de otros miles de usuarios de todo el mundo generan estos rankings de forma orgánica. No hay benchmarks corporativos, ni papers académicos, ni marketing. Solo resultados reales de personas reales usando las IAs para tareas reales. Aunque hay un problema. Lo usuarios suelen tener un sesgo claro hacia respuestas largas y elaboradas, aunque no siempre sean más precisas o haya pequeñas alucinaciones no detectadas. Un modelo que escriba párrafos floridos puede rankear mejor que otro más directo pero correcto. Habrá que ver si con el reciente paper de OpenAI cambia este paradigma.

Ejemplo de cómo funciona. El modelo A lo explica bien, al modelo B le ha faltado tiempo de ponerse a contar nosequé de C++, con código y todo, que no cabía en la captura de pantalla. ¿Tu a quién votarías? Yo voté al A, y tras ello me aparecieron los nombres de los modelos: A = Claude Sonnet 4, B = o3 mini.

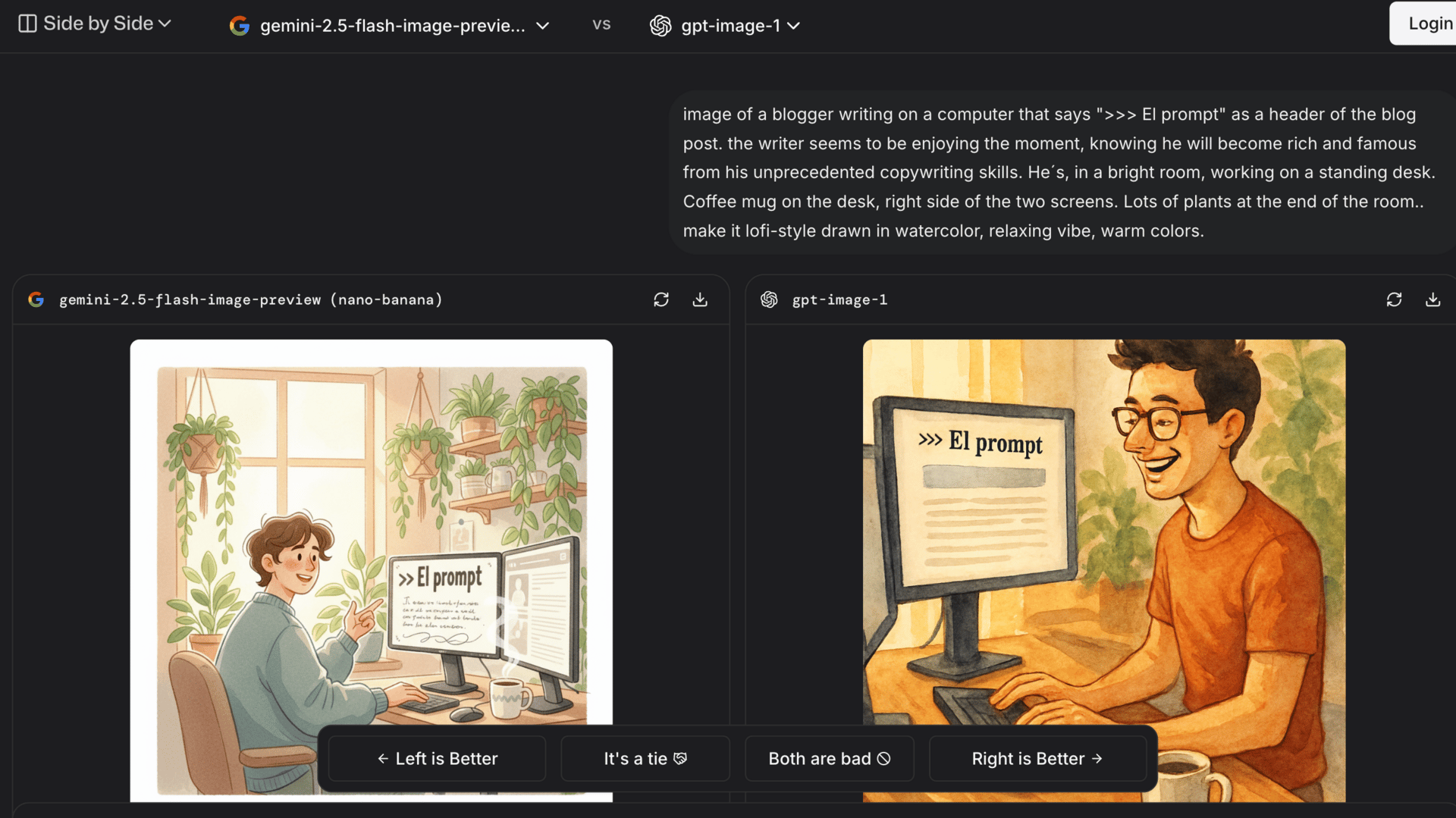

¿Por qué es útil?: LM Arena se ha convertido en el tribunal popular de la IA. Es donde las empresas realmente descubren si su modelo es bueno, o si solo tiene buen marketing. Pero su utilidad va más allá de ver cuál es el mejor modelo actual para cada tarea (que ya es bastante). Además puedes entrar y elegir la batalla que tú quieras con dos modelos que tú elijas o testear simplemente un modelo, sin batalla. Con eso puedo probar modelos de última generación que de otra manera no tendrías acceso sin pagar el premium, como gpt-5 high, o Imagen 4. Mirad cómo con la excusa de "evaluar Nano Banana vs GPT Image 1” me he generado otra imagen para la newsletter, gratis 😏 .

En el ranking, actualizado a 25-Ago-2025, nano-banana (izq.) va primera con 1147 puntos. gpt-image-1 (dcha.) va tercera con 1129 puntos. Con esa nariz que le pone al de la derecha, yo daría como ganador a nano-banana…

Y hasta aquí la entrega #02 de la Newsletter.

¿Qué te ha parecido el email de hoy? Si quieres poner un comentario, podrás ponerlo despues de puntual el post 😀 .

🧠 🧠 🧠 🧠 🧠 ¡Alimento para la mente!

🧠 🧠 🧠 Tienes que pensarlo mejor

🧠 Han faltado neuronas

>>> ¡Nos vemos en la siguiente entrega!